欧州連合(European Union)は域内のAIを規制する法令「AI Act」の最終調整を続けてきたが、難航の末、今月最終合意に達した。2021年に創案された法案が二年の歳月を経て法令として成立する。AI Actの成立に時間を要した理由は、二年間でAIの機能が劇的に進化したことにある。昨年末、ChatGPTという新しいタイプのAIが登場し、この生成AIをどう規制するかで議論が続いた。EUは当初、生成AIに厳しい制限を設けることを主張したが、OpenAIやGoogleはこれに強く反発し交渉が続いてきた。最終的に、生成AIの技術内容を公開するなど、透明性を高めることを義務付ける内容で決着した。

| 出典: European Parliament |

AI Actとは

「AI Act (Artificial Intelligence Act)」とは欧州員会(European Commission)によるAI規制法で、EU内でAIを安全に運用するためのフレームワークとなる。欧州委員会はAIの危険度を四段階に分けて定義し、それぞれの利用法を規定した。危険なAI (Unacceptable Risk AI)はその使用を禁止する。ハイリスクなAI(High-risk AI)については、規定された対策を適用することを条件に使用が認められる。ローリスクなAI(Limited Risk AI)は表示義務を条件に使用が認められる。その他のAI(Minimal Risk AI)は無条件で利用できる。また、これらの規定に違反すると制裁金として、最大3500万ユーロか売上高の7%が課される。AI Actの特徴はAIの危険度を定義し、それに応じた運用条件を定めたことにある。

| 出典: European Commission |

AI Actの最終合意概要

AI Actは最終合意に達したが、法令のテキストはまだ公開されておらず、その詳細は分かっていない。欧州議会は、AI Actの最終合意内容に関しニュースリリースを発表し、法令の骨子を明らかにした。それによると、AI Act最終合意概要は:

- 生成AI:生成AIは「General-Purpose AI (GPAI)、汎用AI」と呼ばれ、それを安全に運用するためのセーフガードが制定された

- 生体情報:顔認識システムを警察などが使うことを制限

- ソーシャルスコアリング:消費者を格付けするAIや心情を操作するAIは使用禁止

- 説明責任: AIの判定理由を消費者に説明することを求める

- 制裁金:最大3500万ユーロか売上高の7%に増額された

生成AIに関する規制

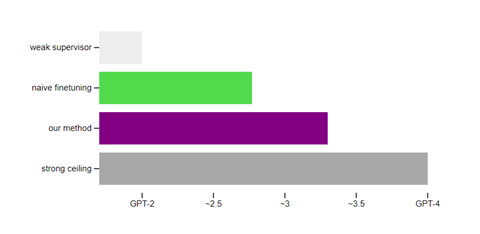

生成AIは「General-Purpose AI (GPAI)、汎用AI」と呼ばれ、安全に運用するためのセーフガード(Safeguard)が制定された。生成AIは幅広いタスクに適用されるため、汎用AIとして定義され、その開発や運用において透明性に関する要件が制定された。システムに関する情報公開を義務付けるもので、下記の項目が規定された:

- 技術ドキュメントの公開

- EUの著作権に準拠すること

- 教育で使用したコンテンツの公開

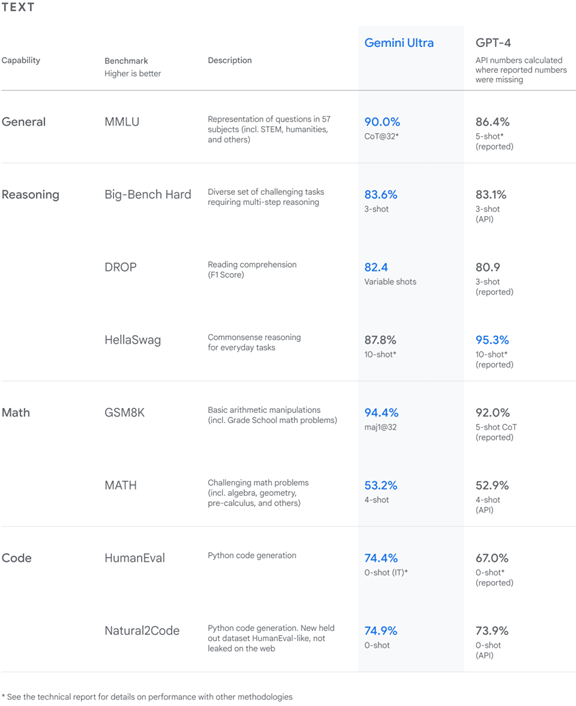

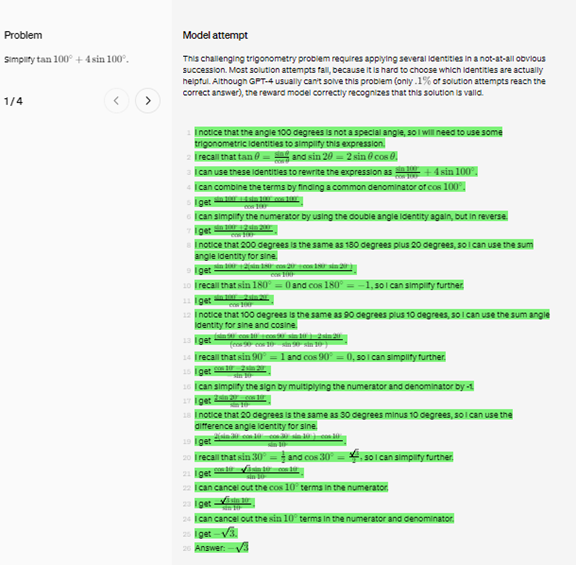

ハイリスクな生成AIに関する規制

ハイリスクな生成AI「High-Impact (GPAI)」については、更に厳しい条件が付加された。ハイリスクな生成AIとは、社会インフラや教育や医療など危険性が高い領域に適用される生成AIを指す。ハイリスク生成AIは、モデルが安全に運用されていることを報告する義務が課された。具体的には、下記の条項が義務付けられた:

- モデルの評価

- システムのリスクを検証し対策を実施

- Red-teamingによる安全試験

- 重大なインシデントを報告

- サイバーセキュリティ対策

- モデル開発に関するエネルギー効率を報告

| 出典: GPT-4 |

顔認識システムに関する規制

AI Actは顔認識システム(Biometric Categorisation Systems)の使用を全面的に禁止した。顔認識システムを政治や宗教の目的で使うことで、個人の権利や民主主義が侵害される。また、この技術のベースとなる、顔イメージをスクレイピングして、データセットを構築することも禁止された。米国企業Clearviewは、ソーシャルメディアから顔イメージを収集し、世界最大規模の顔データセットを開発したが、この手法が明確に禁止された。

警察の使用に関する規定

一方、警察など治安当局が顔認識システムを使うことについては、特定の条件の下で、これを認める内容となった。顔認識システムは犯罪を抑止する効果があり、警察は裁判所の認可の元で、特定の犯罪に限って利用できる。リアルタイムでの顔認識システムについても、誘拐犯人の捜査など、特定の条件に限り使用が認められた。

AI Actの適用スケジュール

AI Actは最終合意に至ったが、適用計画については公表されていない。法令の施行時期は2024年と予想され、これをベースに準備が進められている。危険なAI(顔認識システムなど)については施行日の6か月後に適用され、生成AIについては1年後の2025年に適用される。その他のAIについては、2年後の2026年からの適用となる。AIの機能や性能は短期間で大きく変わり、生成AIが適用される時期に、規定の見直しが必要との意見もある。

| 出典: The White House |

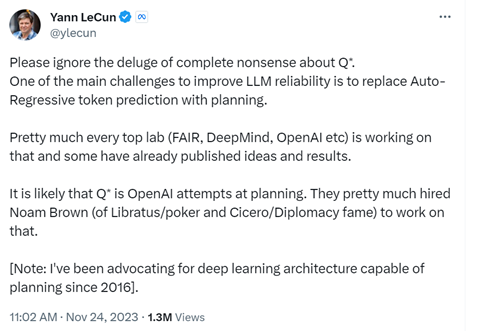

欧州と米国のAI規制のアプローチ

EU AI Actは、バイデン政権のAI規制に関する大統領令と比較して、厳しい内容となっている。EUは、AI Actや「一般データ保護規則(General Data Protection Regulation、GDPR)」など、テクノロジーから国民の権利を守る政策を取る。一方、米国は法令による規制ではなく、業界標準を定め、企業に自主規制を求める政策を取る。但し、生成AIは例外で、その危険性が甚大で、国家安全保障を脅かすため、米国政府は法令による規制を模索している。