Nvidiaは3月18日、開発者会議「GTC 2024」でヒューマノイドロボットの開発プロジェクト「GR00T」を公開した。ヒューマノイドロボットに生成AIを統合し、人間のようなインテリジェンスを持ち、汎用的に稼働するモデルを創り出す。ヒューマノイドロボットのファウンデーションモデルとなり、ロボット開発におけるコア技術を提供する。開発企業はこのプラットフォームを使って独自のヒューマノイドロボットを生成する。

| 出典: Nvidia |

ヒューマノイドロボットの開発

ヒューマノイドロボット(Humanoid Robot)は、人間の形状を模したロボットで「人型ロボット」と呼ばれる。開発者会議の基調講演で、CEOのJansen Huangは、ヒューマノイドロボットの最新技術について解説した(下の写真)。基調講演はビデオでストリーミングされた。Nvidiaがこのモデルに着目する理由は、社会インフラは人間に合わせて造られており、人型ロボットはここで環境を変更することなく、そのまま活躍できるためである。また、生成AIを搭載することにより、ロボットの学習能力が格段に向上し、人間のように汎用的に動けるモデルを生み出すことがゴールとなる。

| 出典: Nvidia |

ロボット開発状況

プロジェクトは「Generalist Robot 00 Technology (RT00T)」と呼ばれ、汎用的に稼働するヒューマノイドロボットを研究開発する。ロボットは汎用基礎モデル(General-Purpose Foundation Model)となり、シミュレーション環境と実社会で学習し、短時間でスキルを習得する。ChatGPTなどが言語に関する基礎モデルであるのに対し、GR00Tは人型ロボットに関する基礎モデルとなる。研究所では多種類のモデルが開発されている(下の写真)。

| 出典: Nvidia |

ロボットを教育する手法

ロボット開発ではシミュレーション環境「Issac Sim」にヒューマノイドのデジタルツインが生成され、この仮想空間でスキルを習得した。ロボットは仮想社会で階段やでこぼこ道で歩行訓練を行い、スキルを学習した(下の写真)。更に、ロボットは開発環境「Isaac Lab」でアルゴリズム教育が実施された。Isaac Labは高度なAIを搭載するロボットの開発環境で、特に強化学習(Reinforcement Learning)のアルゴリズムを教育する環境となる。この他に、模倣学習(Imitation Learning)や転移学習(Transfer Learning)などの手法でロボットはスキルを獲得した。

| 出典: Nvidia |

模倣学習のケース

実際に、ロボットは人間の動作を見てそれを真似る、模倣学習の手法で成果を上げている。人間が動作の手本を示し、ロボットはそれを見て真似ることでスキルを学習する。ロボットが人間のドラマーのプレーを見て、ドラムを演奏するヒューマノイドが紹介された。これはヒューマノイドロボット「Sanctuary AI」の事例で、人間向けに造られた楽器をロボットが演奏した。

| 出典: Nvidia |

ヒューマノイドロボット開発企業

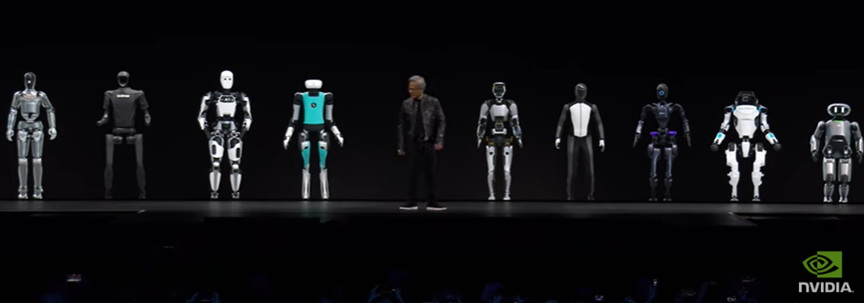

Nvidiaは自社でヒューマノイドロボットを開発するのではなく、その開発環境を提供し、パートナー企業がこの基盤で製品を開発する。基調講演では開発中のヒューマノイドロボットが表示され、エコシステムの広さをアピールした。(下の写真、現在開発中のヒューマノイドロボット、左から、Figure AI、Unitree Robotics、Apptronik、Agility Robotics、(Jensen Huang)、Sanctuary AI、1X Technologies、Fourier Intelligence、Boston Dynamics、XPENG Robotics)。

| 出典:Nvidia |

ロボットと生成AIとの融合

ヒューマノイドロボットがホットな研究テーマになっている。OpenAIはFigure AIに出資し、共同でヒューマノイドロボットの開発を進めている。ロボットに大規模言語モデルを組み込み、人間のようなインテリジェンスを得る。Agility Roboticsの「Digit」は、配送センターで人間の作業員に代わり荷物を搬送する (下の写真、Digitがオーブンからトレイを取り出している様子)。一方、Teslaのヒューマノイドロボット「Optimus」はステージに登場せず、独自方式でモデルを開発している。ヒューマノイドロボットが生成AIと融合し、インテリジェンスが劇的に進化すると期待されている。

| 出典:Nvidia |