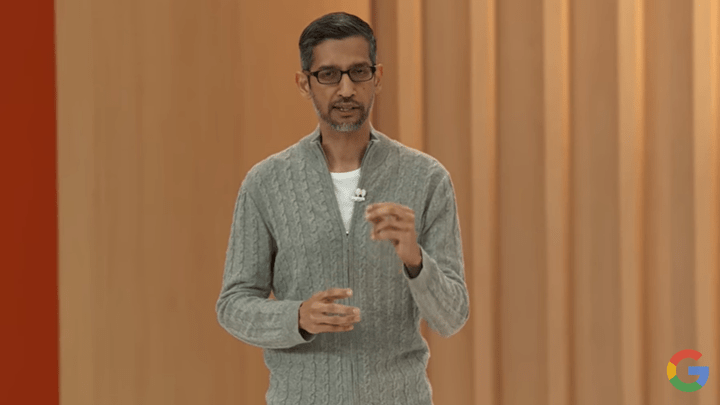

サンフランシスコでセキュリティの国際会議「RSA Conference 2023」が開催された。今年の中心テーマは生成AIで、ChatGPTを悪用した犯罪とその防御方法が議論された。セキュリティ企業は生成AIを活用した次世代の防衛技術を公開した。Googleは世界最大規模の生成AIを開発しており、これをベースにしたセキュリティ技術を公開した。

| 出典: VentureClef |

生成AIによる防衛技術

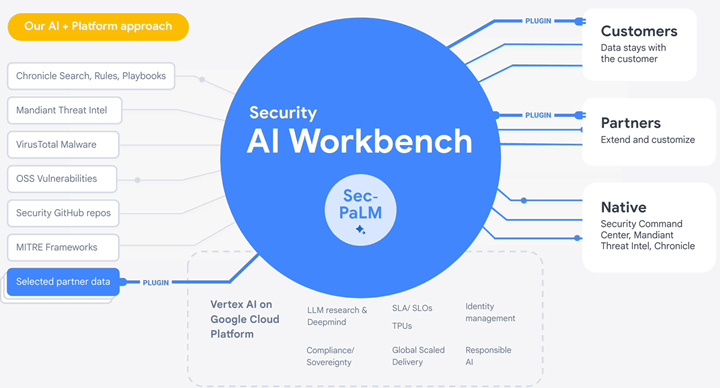

Googleは生成AIを使ったセキュリティ技術「Cloud Security AI Workbench」を公開し、RSA 2023で注目を集めた(上の写真)。AI WorkbenchはGoogleが開発した大規模言語モデル「Sec-PaLM」に構築されるセキュリティ技術で、高精度でマルウェアを検知する機能を持つ。Sec-PaLMとは、名前が示すように、世界最大規模の生成AI「PaLM」をベースとするシステムで、これをセキュリティに特化したモデルにアップグレードした。つまり、世界最大規模のセキュリティ向け生成AIとなる。

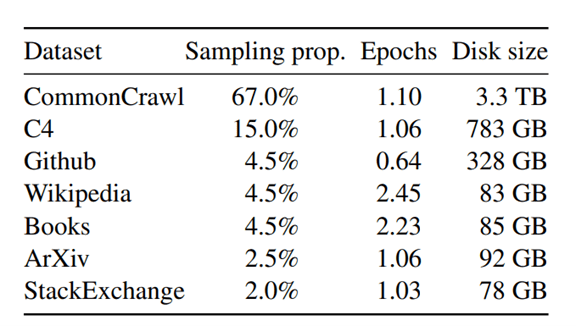

セキュリティ向け教育データ

AI Workbenchの教育では、セキュリティに関する大量のデータが使われ、モデルはマルウェアに関する高度なスキルを学習した(下のグラフィックス)。これは「セキュリティ・インテリジェンス」と呼ばれ、Googleが収集したデータの他に、パートナー企業であるMandiantが保有するデータが使われた。具体的には、システムの脆弱性、マルウェア、攻撃のシグナル、攻撃の特性やその挙動などに関するデータで教育され、アルゴリズムはサイバー攻撃に関する包括的なスキルを学習した。

| 出典: Google |

AI Workbenchの機能

AI Workbenchは世界最大規模の生成AIをベースとするシステムで、セキュリティに関するプロセスを自動化する。AI Workbenchは、システムに対する攻撃を把握し、これに対する防衛機能を自律的に実行する。また、システム全体を検証し、セキュリティに関する問題点などを指摘する。AI Workbenchの主要機能は:

- サイバー攻撃を把握:セキュリティに関する大量のデータ(セキュリティのログや通信トラフィックなど)を解析しサイバー攻撃の兆候を把握する

- サイバー攻撃に対する防御:攻撃に対して自律的に防衛措置(IPアドレスの封鎖やファイルの検疫など)を実施し脅威を低減する

- システムの脆弱性の検査:システム全体を検証してセキュリティ・ギャップなど脆弱性を把握し、セキュリティ強化に関する提言を行う

マルウェア検知のサービス

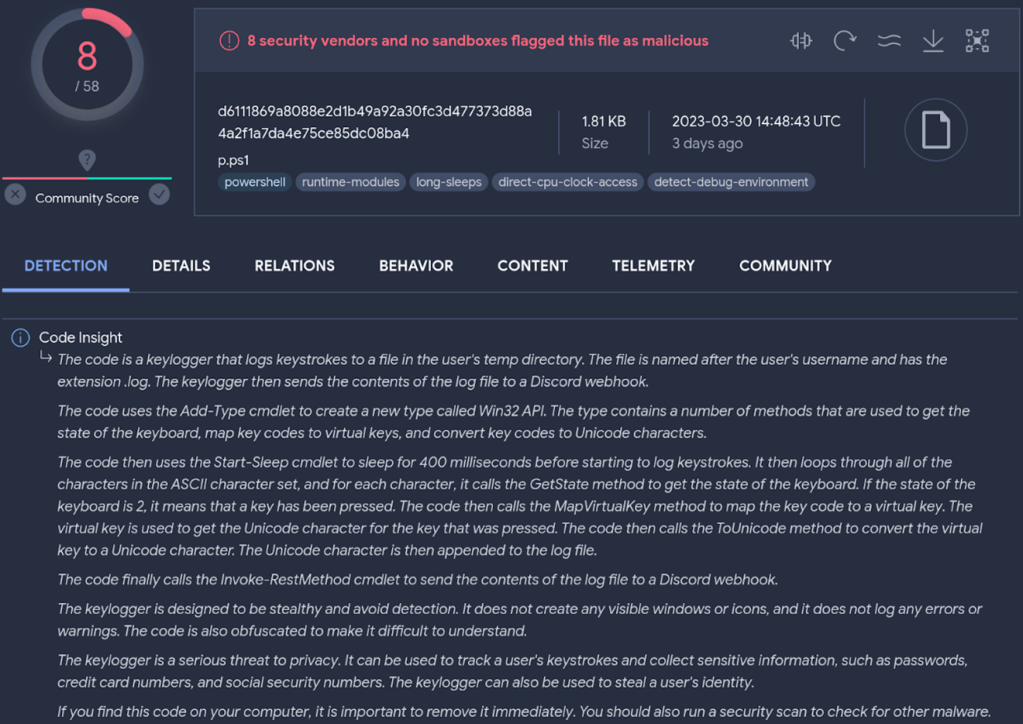

GoogleはAI Workbenchを統合したセキュリティサービス「VirusTotal Code Insight」(下の写真)を開発した。このサービスはコードをスキャンし、それがマルウェアであるかどうかを判定する。その際に、マルウェアである確度(下の写真上段、レベル8)と、マルウェアの特性や挙動を分かりやすい言葉で説明し(下段)、分かりやすいインターフェイスで迅速な対応が可能となる。VirusTotalはGoogleが買収した企業で、マルウェアに関する情報を集約したウェブサイトを運営している。

| 出典: VirusTotal |

攻撃に関する情報検索

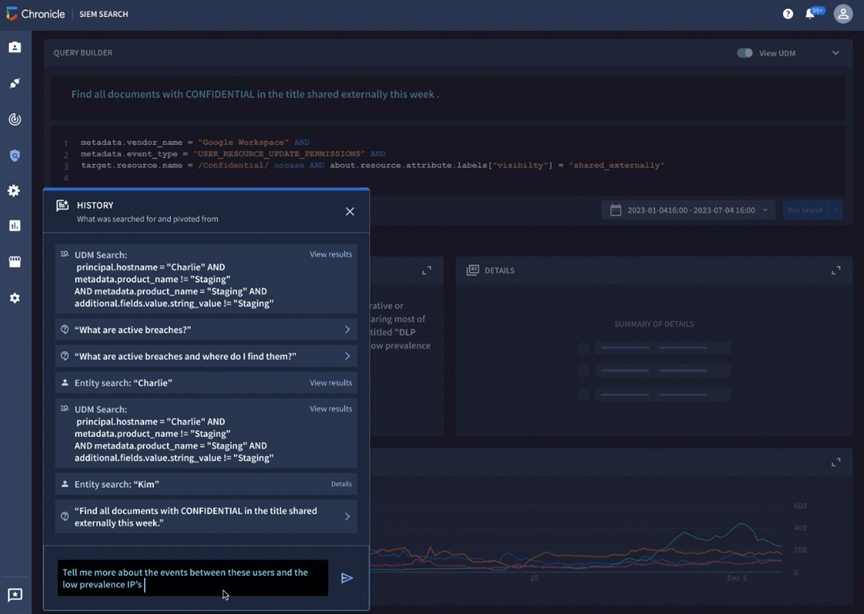

Google Cloudは大量のログデータから攻撃のシグナルを検知するセキュリティ機能「Chronicle Security Operations」を提供している。Chronicle Security OperationsはAI Workbenchを統合し、インテリジェントにサイバー攻撃を検知する技術を提供する。専門家に代わりAIが検索のためのクエリーを生成し、自律的に攻撃を検索し、その結果を分かりやすく表示する。これにより、セキュリティ専門家でなくても、マルウェアによる攻撃を検知できる。(下のスクリーンショットは「CONFIDENTIAL」というタイトルのドキュメントを外部に送信したイベントを検索した事例で、データリークを迅速に検知する)。

| 出典: Google |

AI Workbenchの目的

企業は数多くのセキュリティツールを導入しているが、これらが生成するデータの数は膨大で、これを人間が解析するには限界があり、AI Workbenchがこれを自動化する。また、セキュリティツールを使うには高度な技術を要するが、AI Workbenchがインターフェイスとなり、セキュリティに関する情報を分かりやすく説明する。セキュリティ市場では高度な技術を持つエンジニアが不足しており、人間に代わりAI Workbenchがセキュリティ専門家として機能する。

生成AIで防衛機能を強化

GoogleはAI Workbenchをパートナー企業に提供し、セキュリティ製品に組み込まれて出荷される。その後、一般向けに提供され、企業はAI Workbenchを統合したセキュリティシステムを開発することができる。その際に、企業は所有するデータでアルゴリズムを再度教育し、ビジネスに最適なモデルを構築することができる。ChatGPTの利用が急拡大する中、生成AIでセキュリティ機能を強化する技法が示され、サイバー攻撃への防衛能力が高まると期待されている。