OpenAIは5月13日、フラッグシップモデル「GPT-4o(Omni)」をリリースした。GPT-4oはGPT-4 Turboと同等の性能を持つが、処理速度が2倍向上し、人間とリアルタイムで会話できる。また、GPT-4oはビジョンとオーディオ機能が進化し、画像や音声の理解力が深まった。GPT-4oはAIエージェントとして、人間とAIが自然なインターフェイスで対話できるようになった。ついに、アメリカSF恋愛映画「Her」(世界でひとつの彼女)の時代が到来した。

| 出典: OpenAI |

GPT-4oとは

GPT-4oは「Omni」を意味し、マルチメディア(テキスト、オーディオ、イメージ、ビデオ)をネイティブで処理できるAIモデルとなる。GPT-4oは処理速度が格段に向上し、320マイクロセカンドで反応する。これは人間の反応速度と同等で、AIモデルが人間と自然な速度で会話できるようになった。GPT-4oの言語能力はGPT-4 Turboと同等であるが、処理速度が格段に向上し、対話できるAIエージェントとなった。OpenAIは発表イベントで、GPT-4oの多彩な機能を実演した。

ビデオ画像の理解:イベントの予測

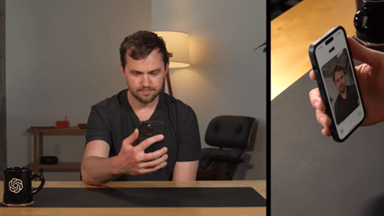

GPT-4oはスマホのChatGPTアプリから利用する。カメラをオンにして、ビデオ会議の形式でGPT-4oと対話する。GPT-4oはビデオと音声を理解し、会話の内容だけでなく、人物や背景の画像を理解する。GPT-4oはスマホカメラの画像から、これから何が始まるかを予測する。下の写真:GPT-4oは人物の衣服やオフィスの雰囲気から、これからライブストリームが始まると推測した。(ビデオのURL:https://www.youtube.com/watch?v=vgYi3Wr7v_g)

| 出典: OpenAI |

社会常識の理解:人事面接のアドバイス

GPT-4oは利用者の服装に関するアドバイスする。下の写真:「これからOpenAIで人事面接を受けるが、服装についてアドバイスしてほしい」とリクエストすると、GPT-4oは「髪の毛を整えて。。。面接官に情熱をアピールすることが重要」と助言。GPT-4oは社会通念を理解しており、利用者のイメージと比較して解析結果を提示した。(ビデオのURL:https://www.youtube.com/watch?v=wfAYBdaGVxs)。

| 出典: OpenAI |

ステップごとに推論する機能:数学の先生

GPT-4oは学校の教師として生徒に勉強を指導する。下の写真:ここではGPT-4oが数学の先生となり、生徒に「sin α」について解説。GPT-4oは提示された問題のイメージを読み込み、ステップごとに解法を説明し、最終的に問題を解くところに導く。対話形式で進み、GPT-4oの問いかけに、生徒が答え、生徒が間違えるとGPT-4oはその理由を説明する。GPT-4oの推論機能を数学の解法に適用した事例となる。(ビデオのURL:https://www.youtube.com/watch?v=_nSmkyDNulk)。

| 出典: OpenAI |

発言内容を理解する機能:テレビ会議に出席し議事録を作成

GPT-4oはテレビ会議に出席し、参加者の発言を聞き、独自の意見を述べることができる。また、会議の最後に、GPT-4oは議事のサマリーを口頭で示す。下の写真:四人から構成されるテレビ会議にGPT-4oが参加し、犬が好きか・猫が好きかのディスカッションが進む。GPT-4oは、「犬は飼い主に忠実であり。。。猫は手間がかからなくキュートである」と自分の意見を提示。会議の最後に、司会者がGPT-4oに議論の概要を纏めるよう指示すると、これに従って要旨を述べる。(ビデオのURL:https://www.youtube.com/watch?v=kkIAeMqASaY)。

| 出典: OpenAI |

独立したエージェント:GPT-4o同士の会話

GPT-4oは別のGPT-4oと会話することができる。下の写真:人間(Greg Brockman)が条件を設定し、これを二つのGPT-4oに告げる。ここでは、GPT-1(左側)は音声を聞くことができ、もう一方のGPT-2(右側)はこれに加え、カメラで周囲の画像を見ることができる。この設定で、GPT-1はGPT-2に対し、「カメラで周囲の情景を撮影しその様子を話してほしい」とリクエスト。これに対しGPT-2は指示されたタスクを実行し、周りのイメージを言葉で伝える。このデモで、GPT-4o同士の会話が成立し、GPT-4oは独立したエージェントとしての機能を持つことが示された。(ビデオのURL:https://www.youtube.com/watch?v=MirzFk_DSiI)。

| 出典: OpenAI |

リアルタイムで会話できる理由

GPT-4oがリアルタイムで利用者と会話できるのは「Voice Mode」の処理が格段に高速化されたことによる。Voice Modeとは話し言葉で会話するモードで、このプロセスの処理に時間がかかる。具体的には、1)利用者のボイスをテキストに変換、2)テキストをAIモデルが処理、3)解析結果のテキストをボイスに変換、という三段階のプロセスを経るため時間を要す。GPT-4oはこのプロセスを大幅に改良し、利用者のボイスをそのまま読み込み、AIがこれを処理する構造となり、反応時間が格段に短縮した。GPT-4では反応時間が5.4秒かかるが、GPT-4oはこれを0.32秒で実行し、リアルタイムの会話ができるようになった。

アーキテクチャ

これはGPT-4oのアーキテクチャが改良されたためで、マルチモダルのデータを処理できるようになった。従来のGPT-4はテキスト、ビジョン、オーディオをそれぞれ専用のネットワークで処理していたが、GPT-4oは単一のネットワークがテキスト、ビジョン、オーディオを処理する。これにより、処理速度が向上したことに加え、声のトーンやカメラのビデオ画像などを理解でき、人間のようにマルチモダルで情報を把握する。

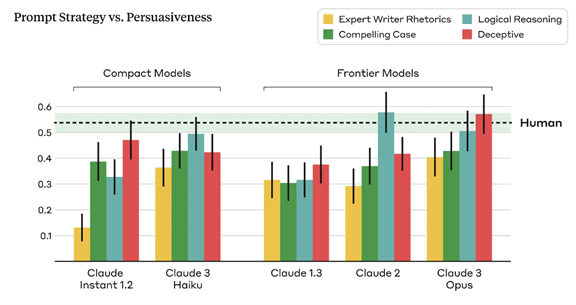

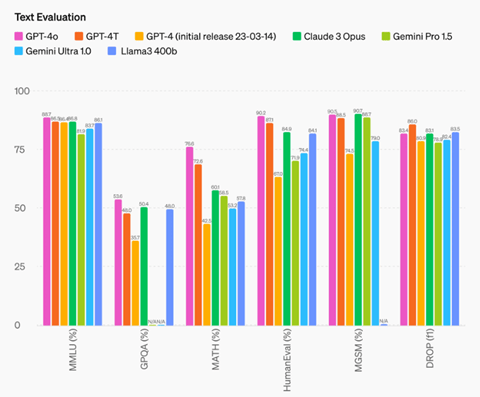

ベンチマーク

OpenAIはベンチマーク結果を公表し、GPT-4oは処理速度が高速化されただけでなく、基本性能が向上した(下のグラフ)ことを明らかにした。AIの推論能力(MMLU (general knowledge questions))では業界トップの性能を奪還した(左端)。また、AIの視覚機能(Vision understanding evals)でも業界トップの性能を示した。

| 出典: OpenAI |

これは「Her」なのか議論沸騰

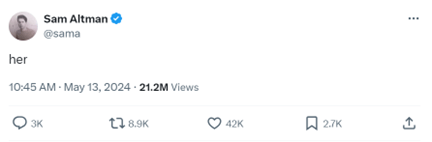

GPT-4oに関して、これはAIエージェントなのか、それともチャットボットなのか、研究者の間で議論が沸騰している。ある研究者は、GPT-4oは仮想の人物で、視覚、会話、聴覚、推論機能を持ち、普通の人間と区別できない、と述べている。別の研究者は、GPT-4oはSF恋愛映画「Her」のAIエージェントであるSamanthaである、と述べている。これに対し、Sam Altmanはツイッターで「her」と答え、このSF映画を手本にしていることを示唆した(下の写真)。

| 出典: Sam Altman |

SF映画Herの時代

「Her」は2013年に公開されたアメリカのSF映画で、ロスアンゼルスに住む寂しい男性Theodore Twombly(下の写真)が、パソコンの中の女性AIエージェントSamanthaに恋するストーリー。Samanthaは基本ソフトのアップグレードで、人間のように自我や人格を持ち、男性と会話を通して親密になる。TheodoreとSamanthaはお互いに惹かれあったが、彼女は男性の元を去るという物語となる。

| 出典: Warner Bros. Pictures |

声の所有権

GPT-4oは5種類の声を持つが、その一つ「Sky」がSamanthaの声で、SF映画のストーリーが現実のものとなった。Samanthaの声を女優Scarlett Johanssonが務めた。JohanssonはGPT-4oが許可なく声を使っているとしてOpenAIを提訴した。OpenAIは別の声優の声を使ってGPT-4oを教育したと説明し、法的な問題は無いとの立場を取っている。AIエージェントが人間に好まれる声を持つことは必須要件で、これから声の所有権についての協議や議論が進むことになる。