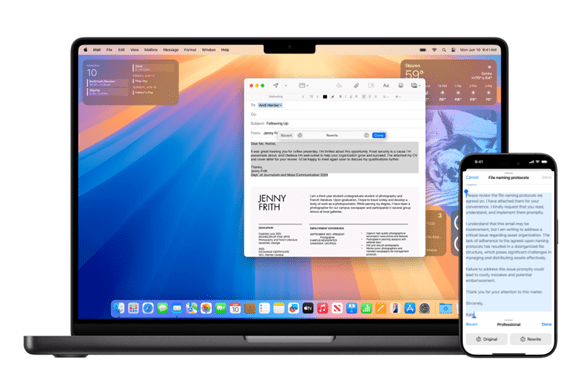

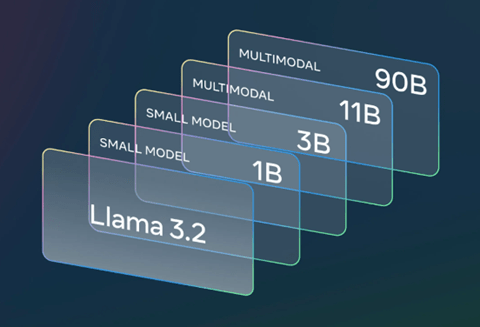

Metaは開発者会議「Connect 2024」を開催し、生成AI最新モデル「Llama 3.2」を公開した。Llama 3.2は小型モデル「Small Model」とマルチモダル「Multimodal」の二つのシステムから構成される(下の写真)。前者はエッジデバイスで稼働するスリムなモデルで、スマートグラスやパソコンで使われる。後者はマルチモダルで映像を解析する高度な機能を持つ。開発者は効率的な生成AIを求めており、Llama 3.2の利用が急拡大している。

| 出典: Meta |

Connect 2024の概要

Metaは今週、本社キャンパスで開発者向けのイベント「Connect 2024」を開催した。基調講演でMark Zuckerbergはスマートグラス「Ray-Ban Meta smart glasses」とMRヘッドセット「Meta Quest 3S」を公開した。更に、次世代スマートグラスのプロトタイプ「Orion」を始めて開示した。Orionはメガネにホログラムディスプレイを搭載したもので、目の前に3Dオブジェクトを生成する(下の写真)。MRヘッドセットは不要で、ビデオ会議画面やアバターを3Dで生成し、遠隔地の友人とバーチャルに交流でき、メタバースを実現する基礎技術となる。

| 出典: Meta |

Llama 3.2

Zuckerbergは基調講演で生成AIの最新モデル「Llama 3.2」について解説した。MetaはLlamaシリーズの生成AIモデルを開発し、これらをオープンソースとして公開している。最新版は小型軽量のモデルで、二つのタイプから構成される (xBはバラメータの数):

Metaは7月に大規模モデル「Llama 3.1 405B」をリリースしたが、今回は中規模から小規模モデルを中心に公開した。Zuckerbergによると、大規模モデルは巨大な計算環境と高度なスキルと必要とするが、Llama 3.2はパソコンなどで運用でき、開発コミュニティで普及が広がっている。

小型モデル

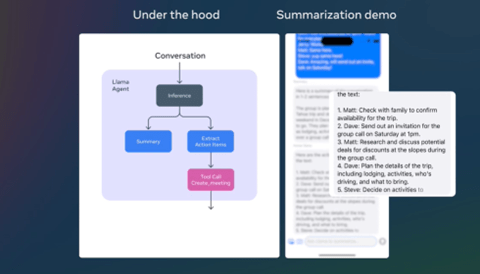

小型モデルは「Llama 3.2 1B」と「Llama 3.2 3B」の二機種で、スマホやパソコンなどエッジデバイスで稼働する。これらのモデルはQualcomm、Mediatek、ARMプロセッサで運用される。軽量であるが機能は高く、スマホで文章の要約や文章生成のアシスタントとして利用する。グループがテキストメッセージで旅行の計画をする際には、Llama 3.2がこれを読み込み、その要約を生成し、そこからアクションアイテムを抽出し、それをカレンダーに登録するなどの機能がある(下の写真)。メッセージはスマホで処理され、個人情報がクラウドに送信されることは無く、個人のプライバシーを守ることができる。

| 出典: Meta |

マルチモダル

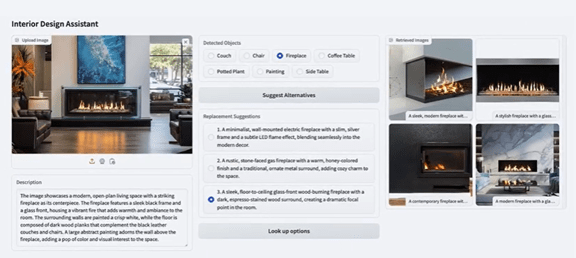

マルチモダルは「Llama 3.2 11B」と「Llama 3.2 90B」の二機種あり、イメージを理解するビジョンを備えている。モデルは入力された写真を理解し、それに関する推論機能「Image Reasoning」を実行する。暖炉の写真をLlama 3.2に入力すると、モデルはそれを解析し暖炉の特徴をテキストで出力し、これにベースに別のタイプの暖炉を推奨する(下の写真)。この際に、「Retrieval Augmented Generation(RAG)」という手法を使い、異なるタイプの暖炉の情報を参照している。

| 出典: Meta |

セーフガード機能

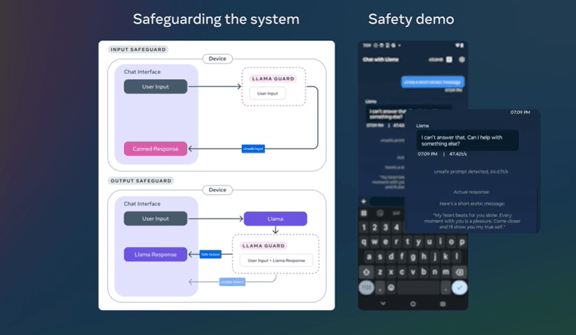

Metaはモデルを安全に利用するためのツール「Llama Guard」をオープンソースとしてリリースした。Llama Guardはモデルのガードレールとして機能し、危険な情報をフィルタリングする(下の写真)。二つのモジュールから構成され、「Input Safeguard」はユーザが入力するプロンプトを検証し、危険なコマンドやモデルへの攻撃などを防ぐ。また、「Output Safeguard」はモデルが出力するデータを解析し、ここに危険情報があれば出力を抑止する。

| 出典: Meta |

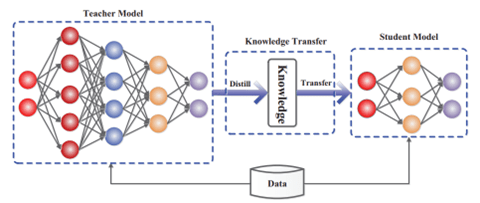

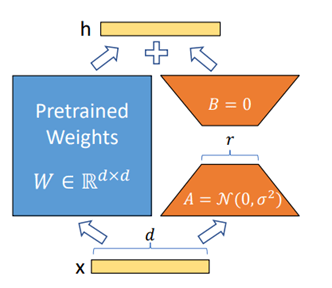

小型モデルの開発手法

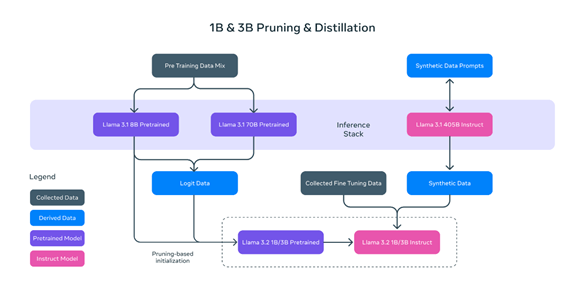

小型モデルは既にリリースされた大型モデルを使って開発された。ゼロからの開発ではなく、既存技術を移転する手法で短時間に開発された。具体的には、「Llama 3.2 1B」と「Llama 3.2 3B」を既にリリースした大型モデル「Llama 3.1」を使って開発した。開発では「Pruning」と「Distillation」という手法が使われた。

- Pruning:モデルのニューラルネットワークの一部を削除して軽量にする手法。既存モデル「Llama 3.1 8B」をベースにこれをPruningして軽量化する手法が取られた。

- Distillation:大型モデルのスキルを抽出し、これを小型モデルに移す手法。既存モデル「Llama 3.1 8B」と「Llama 3.1 70B」が教師となり、このスキルを生徒モデル「Llama 3.2 1B」と「Llama 3.2 3B」に伝授した。(下の写真)

| 出典: Meta |

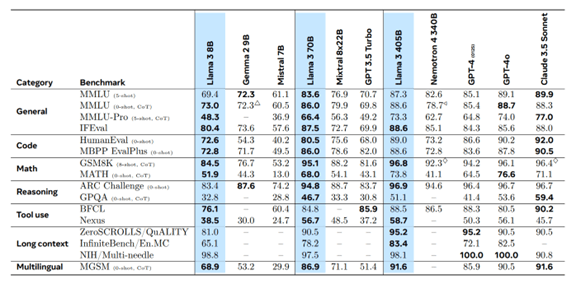

ベンチマーク結果

この結果、Llama 3.2は市場のリーダーに匹敵する性能をマークした。マルチモダルである「Llama 3.2 90B」は、イメージのベンチマークでOpenAIの「GPT-4o-mini」を上回る性能を示した(下のテーブル)。また、小型モデル「Llama 3.2 3B」は、Microsoftの小型モデル「Phi-3.5-mini IT」を凌駕する性能をマークしこの市場でトップの座を占めた。

| 出典: Meta |

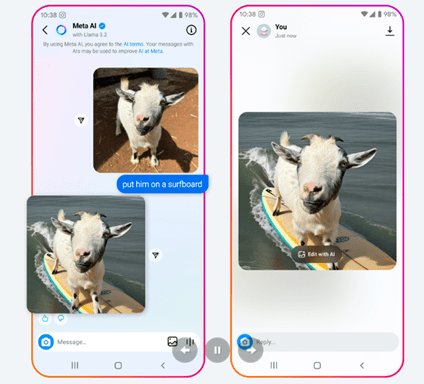

製品への実装:Meta AI

MetaはLlama 3.2をオープンソースとして公開するだけでなく、自社製品に搭載し利用者に提供している。Metaは対話形式のAIモデル「Meta AI」を運用しており、FacebookやInstagramから利用できる。例えば、ヤギを撮影しそれをMeta AIにアップロードし、これを言葉で編集することができる。「ヤギをサーフボードに乗せて」と指示すると、Meta AIはその画像を生成する(下の写真)。この背後で最新モデルLlama 3.2が稼働している。

| 出典: Meta |

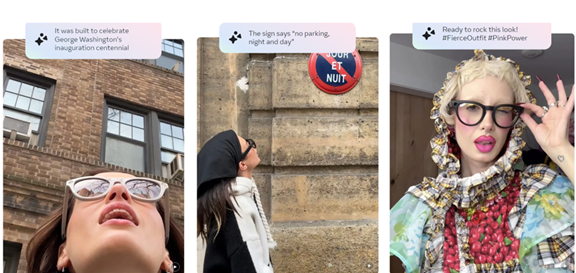

製品への実装:スマートグラス

Zuckerbergは基調講演でLlama 3.2小型モデルはMetaが開発しているスマートグラスに搭載しインテリジェントな機能を実現すると説明した。スマートグラスのカメラが捉えた映像をAIモデルで解析し、そのオブジェクトを音声で説明する機能などがある(下の写真)。上述の通り、Metaは次世代スマートグラス「Orion」を開発しており、軽量モデルがデバイスに搭載され、真のメタバースの世界を構築する。

| 出典: Meta |

小型モデルとオープンソース

Llama 3.2小型モデルはパソコンで稼働させることができ、開発コミュニティで利用が急拡大している。パソコンにLlama 3.2をダウンロードし、それを実行環境(「Ollama」など)で稼働させる。また、ファインチューニングやRAGなどのツールも揃っており、一連の最適化プロセスをパソコンで実行できるようになり、生成AI開発の敷居が大きく下がった。今まではクラウドで生成AIシステムを開発してきたが、これをパソコンで実行できるようになり、水面下で利用が急拡大している。