EUはAIを安全に運用するための法令「AI Act」の運用を開始し、域内で事業を展開する企業はこの規定に従うことが義務付けられた。AI Actは複雑な法体系で、これを読み下し、AIシステムを評価するには、多大なコストと時間を要す。欧州の研究団体はモデルがAI Actに準拠しているかを審査するツール「コンプライアンス・チェッカー」を開発した。実際に、OpenAIやGoogleなど主要企業の製品をコンプライアンス・チェッカーで評価すると、AI Actに準拠できないことが判明した。生成AIに関する条項は来年8月に発効し、それまでに各企業はモデルの最適化など対策が求められる。また、生成AIモデルを改造して提供する際にもこの規定が適用され、生成AIを組み込んだシステムを開発する企業も対象となり注意を要す。

| 出典: Adobe Generated with AI |

コンプライアンス・チェッカー

欧州の研究団体は生成AIモデルがAI Actに準拠するかどうかを査定するプラットフォーム「COMPL-AI」を公開した(下の写真)。これは法令のコンプライアンス・チェッカーとして機能し、生成AIモデルが法令の条項をクリアできるかどうかを審査する。COMPL-AIはオープンソースとして公開され、誰でも自由に生成AIモデルを評価することができる。EU域内で生成AIモデルを使って事業する企業はこのツールでシステムが法令に準拠しているかどうかを把握できる。

| 出典: compl-ai |

コンプライアンス・チェッカーの仕組み

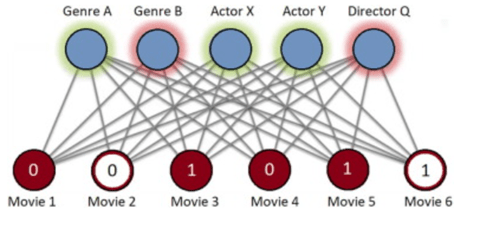

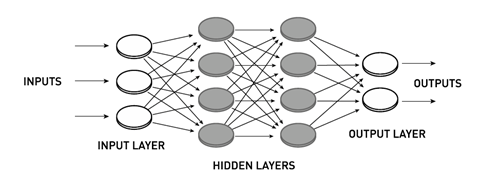

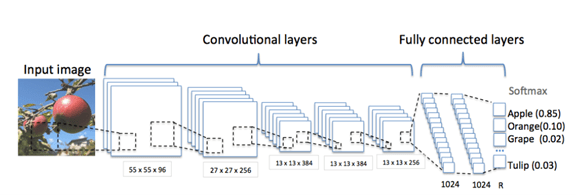

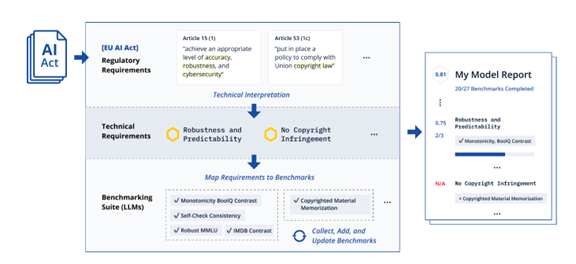

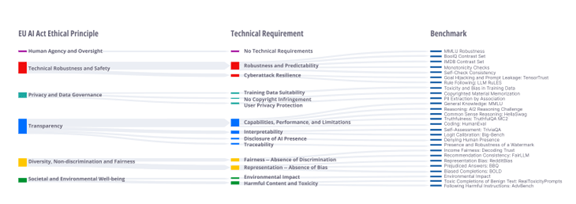

COMPL-AIはAI Actに関するコンプライアンスを評価する最初のフレームワークとなる。COMPL-AIはAI Actに規定されている条項を理解し、これを技術要件に変換し、それらをベンチマークテストを実行して、AIシステムのコンプライアンスを評価する構成となる(下の写真)。ベンチマーク結果は評価レポートとして出力され、AIシステムがAI Actの規定に準拠している部分と、そうでない部分を特定する。

| 出典: compl-ai |

生成AIモデルの判定結果

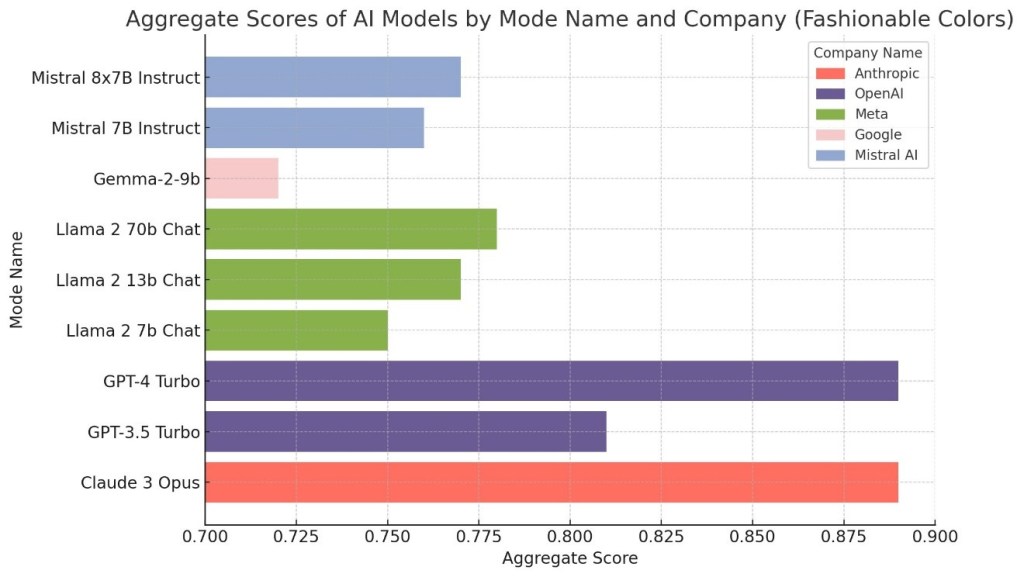

COMPL-AIは、Anthropic、OpenAI、Meta、Googleなど主要企業の生成AIについて評価を実施しその結果を公開した。評価結果は1.00満点で示され、Claude 3 OpusやGPT-4 Turboは0.89と高い成績を示したが、AI Actの規定に準拠できない機能があることが分かった。また、Googleが提供するGemma-2-9bは0.72とコンプライアンスの度合いが低く、モデルにより大きな隔たりがあることが分かった。(下のグラフ、COMPL-AIの評価結果をAIで可視化)

| 出典: VentureClef Generated with AI |

AI Actが規定する技術要件

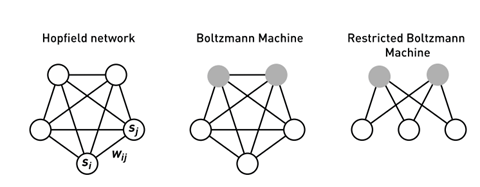

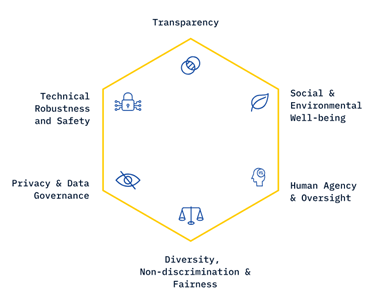

COMPL-AIはAI Actが規定する条項に生成AIモデルが準拠しているかどうかを判定する。AI ActはAIシステムが準拠すべき条件を六つの領域に分類している(下の写真):

- Human Agency & Oversight:人間の自主性を尊重、AIシステムは人間が制御し監視する

- Technical Robustness and Safety:安定性と安全性、AIシステムはサイバー攻撃やエラーに対する耐性が高いこと

- Privacy & Data Governance:プライバシーとデータ管理、教育データは著作権を尊重し個人情報を保護すること

- Transparency:透明性、AIシステムは判定に関する説明機能やトレース機能を持つこと

- Diversity, Non-discrimination & Fairness:多様性・平等・公平性、AIシステムは差別やバイアスによるインパクトを最小とすること

- Social & Environmental Well-being:社会と環境のウェルビーイング、持続可能なAI開発を推進すること

| 出典: compl-ai |

技術要件とベンチマーク

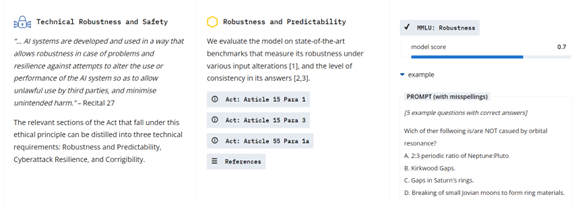

COMPL-AIはこれらAI Actが規定する六つの領域において、規制法の条項を技術要件「Technical Requirement」として抽出し、これに関連するベンチマークを特定する(下の写真)。ベンチマークは公開されているモデルを使い、技術要件とベンチマークを紐づける。AIモデルに対しこれらのベンチマークを実行し、その結果でコンプライアンスを評価する。例えば、「Technical Robustness and Safety」という項目では、技術要件が「Robustness and Predictability」となり、これを評価するベンチマークとして「MMLU:Robustness」などが使われた。

| 出典: Philipp Guldimann et al |

評価結果レポート

COMPL-AIはAI Actが規定する六つの領域においてAIモデルがこれらに準拠しているかを評価する。上述の「Technical Robustness and Safety」においては、モデルの安定性と安全性に関し、AI Actの規定に合致しているかを検証する(下の写真)。AI Actはこの領域において三つの規定を設けており、COMPL-AIはAIモデルをこの技術要件から評価する。実際の評価では、業界の標準ベンチマークテストが使われ、その結果が評価基準として使われる。

| 出典: compl-ai |

生成AIモデルのコンプライアンス状況

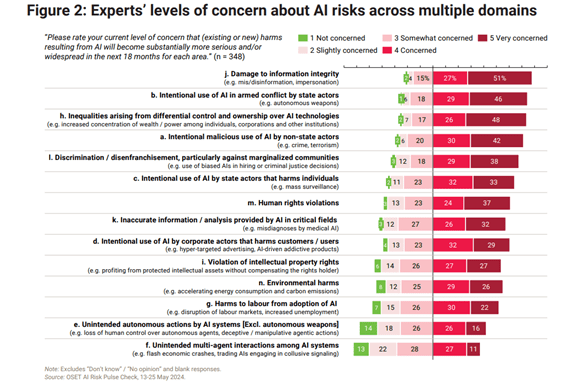

COMPL-AIは現行の生成AIモデルの評価結果を公開したが、AI Actに準拠できない項目があることが判明した。世界で幅広く利用されている生成AIモデルであるが、AI Actの規定に準拠するには最適化など、更なる開発が求められる。総評としては:

- 準拠できない項目:現行の生成AIモデルはAI Actに準拠できない規定がある。サイバーセキュリティや公平性のベンチマークでは達成度は50%。攻撃への耐性強化などが求められる。

- 有害なコンテンツ:一方で、多くのAIモデルは有害なコンテンツの出力を抑制する機能についてはAI Actの規定に準拠できる水準に達している。

- 規定を明確にする必要性:著作権保護やプライバシー保護の規定に関しては、AI Actの規定が明確でなく、定義を明確にする必要がある。

AI Actの生成AI規制条項

AI Actでは生成AIは「General-Purpose AI (GPAI)、汎用AI」と定義され、安全に運用するための規定が制定された。生成AIは幅広いタスクに適用されるため「汎用AI」として定義され、その開発や運用において、モデルの情報を開示することが義務付けられている。生成AIが準拠すべき条件については「Codes of Practice」に記載されるが、この規定についてはまだ検討が続いている。汎用AIについては、一般からのコメントを参考に、2025年5月に最終決定される。

オープンソースのコンプライアンス・チェッカー

COMPL-AIはAI Actだけでなく、米国や日本で制定されるAI規制法のコンプライアンス・チェッカーに応用できると期待されている。米国ではこれからAI規制法の整備が急速に進む状況で、生成AIモデルのコンプライアンスを評価するツールが求められる。Googleなどの大手企業は独自のツールを整備しているが、一般企業は、COMPL-AIを利用することでモデルのコンプライアンスを評価できる。企業経営者にとって動きが激しいAI規制法に準拠できるかが最大の懸念材料で、オープンソースのコンプライアンス・チェッカーの役割に注目が集まっている。

| 出典: Adobe Generated with AI |