OpenAIは10月29日、AGI開発に向けた企業の将来像を明らかにした(下の写真)。OpenAIは一般市民がAGIの恩恵を享受できるシステムを提供することをミッションとする。AGIは超人的なシステムではなく、OpenAIはこれをエージェントとして実現する。また、OpenAIはAGIを提供するプラットフォーム企業に転身する。開発者はこの基盤の上でAGIアプリケーションを開発する。AGIの開発と運用のために30ギガワットのデータセンタを建設し、総工費は1.4兆ドルとなる。

| 出典: OpenAI |

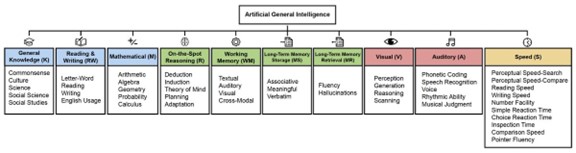

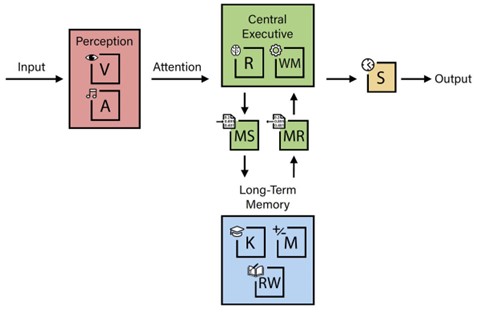

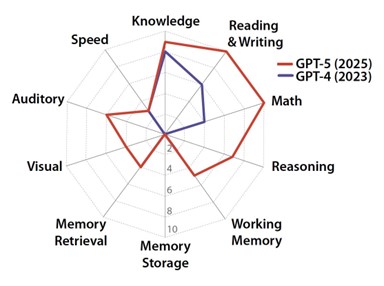

AGIに関する理解と出荷時期

OpenAIはAGIの恩恵を万人が享受できる技術を提供することをミッションとする。AGIに関する共通の理解が確立されていない中、OpenAIはAGIをエージェントやツールとして提供し、そのメリットを可視化する開発戦略を取る。OpenAIはAI研究を自動化するモデル「Automated AI Research」の出荷時期を明らかにした。これは科学研究のエージェントで、ベータモデルと最終モデルのロードマップを公表した(下の写真)。これは、次世代モデル”GPT-6”を2026年9月に、”AGI”を2028年3月に出荷する、と解釈できる。

| 出典: OpenAI |

プラットフォーム企業

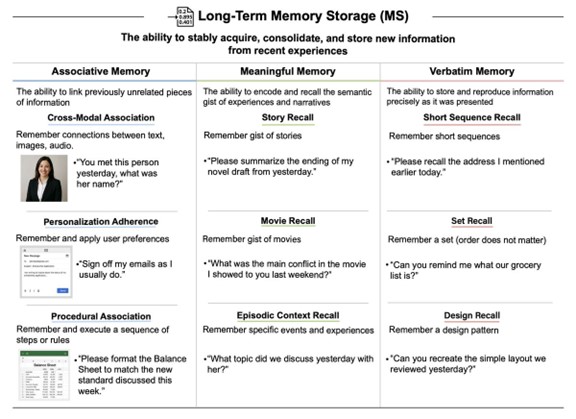

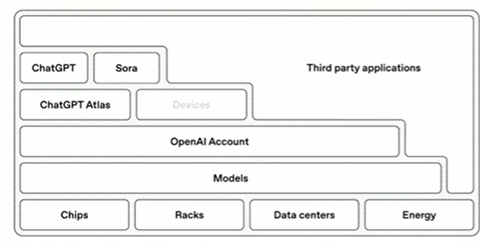

OpenAIはChatGPT企業からAGIプラットフォーム企業に転身すること表明した。OpenAIはAGIプラットフォームのフルスタックを開発し(下の写真)、AIモデルだけでなくハードウェアの開発に着手する。具体的には、半導体、データセンタ、発電などハードウェアから、AIモデル(GPT-5)、ブラウザ(Atlas)、アプリケーション(ChatGPT)までを垂直統合する。キーポイントはユーザインタフェースで、OpenAIはAIブラウザ「ChatGPT Atlas」を投入し、また、スマホに代わるAIデバイスを開発している。これらがAGIを利用するポータルとなる。更に、提携企業はこのプラットフォームでアプリケーションを開発し広大なエコシステムを構築する。

| 出典: OpenAI |

データセンタの建設

OpenAIは半導体やデータセンタなどハードウェア階層をパートナ企業と共同で開発する戦略を取る(下の写真)。半導体開発ではBroadcomと提携し独自のAIプロセッサを開発する。AIクラウドではMicrosoftとの関係を維持し、新規にOracleやGoogleと提携しリソースを利用する。これらに加え、OpenAIは独自のデータセンタを建設しており、ここでNvidiaやAMDのプロセッサを利用する。

| 出典: OpenAI |

Project Stargate

OpenAIはデータセンタプロジェクト「Stargate」を起動し、テキサス州アビリーンに巨大な施設を建設している(下の写真)。第1期の工事が完了し、OpenAIはOracle Cloud経由で計算環境にアクセスする。この施設は建設中のサイトを含め1ギガワットの計算能力を持つ。テキサス州以外にも、ウィスコンシン州など全米5か所にメガセンタを建設する。

| 出典: OpenAI |

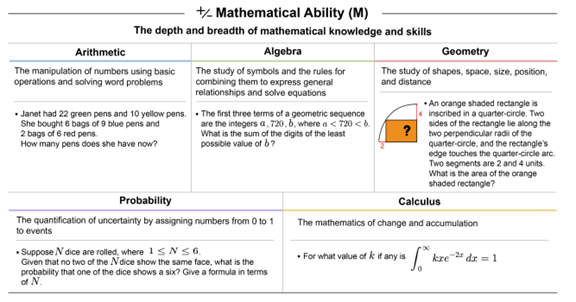

データセンタの規模

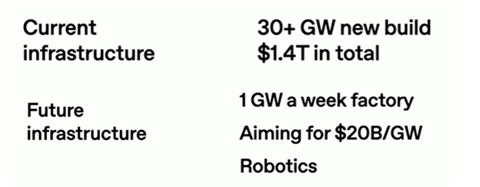

OpenAIはAGIの開発と運用には膨大な計算量が発生し、そのために巨大なデータセンタを建設する(下の写真)。現時点で、OpenAIは30ギガワット超のデータセンタを建設する計画で、総コストは1.4兆ドルとなる。更に、長期ビジョンとして、建設したデータセンタを定常的に拡張し、そのペースは毎週1ギガワットの計算機を増設する。そのコストは1ギガワットあたり200億ドルを目指している。更に、データセンタの建設はロボットを使い、プロセスを自動化しスケーラビリティを上げる。

| 出典: OpenAI |

1ギガワットのサイズ

データセンタの計算容量はプロセッサの消費電力ギガワットで表示される。1ギガワットのデータセンタとは、設置しているプロセッサや冷却装置の消費電力が1ギガワットとなる。新設のデータセンタはNvidiaの最新GPU「Blackwell」が使われる。製品としては「GB200 NVL72」ラックで、72個のGPUが搭載され、消費電力は120 kWとなる。1ギガワットの電力消費量は8,300ラックに相当し、GPUの数では60万個となる。 (下の写真、GB200 NVL72で構成するデータセンタ、32,000GPU構成。1ギガワットのデータセンタにはこのシステムが18ユニット設置される) 因みに、1ギガワットとはサンフランシスコ市の電力消費量に匹敵する。

| 出典: Nvidia |

組織構造を改定

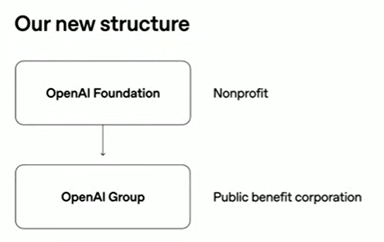

OpenAIはこれに先立ち組織再編を完了した。新組織は非営利団体「OpenAI Foundation」がパブリック・ベネフィット・コーポレーション「OpenAI Group」を統括する構造となる(下の写真)。パブリック・ベネフィット・コーポレーションは営利団体であるが、同時に、公益を実現するハイブリッドな構成となる。これにより、OpenAI Groupは資金を調達し、株式を公開し、事業を遂行することができる。一方、OpenAI FoundationはOpenAI Groupの26%を保有し、会社運営を統括する。OpenA FoundationはOpenAI GroupがAGIを安全に開発し運用するのを監視する役割を担う。また、OpenAI FoundationはヘルスケアとAI安全性に関し資源を拠出し、これらの研究推進を支援するとしている。

| 出典: OpenAI |

AGIの応用分野

OpenAIはAGIをサイエンス研究エージェントとして実現し、科学技術開発を加速することを目指している。具体的には、新薬開発、ヘスケア、ロボティックス、核融合発電、個人に特化した教育、新素材開発などを対象とする。新薬開発ではガンの治療薬の開発などがターゲットで、20年かかる研究を2年に圧縮する。これにより、ここ数年で人間の寿命が75歳から150歳になると期待されている。

| 出典: OpenAI |

データセンタ建設ラッシュ

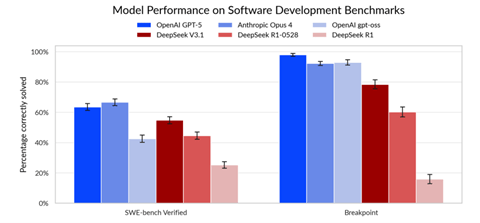

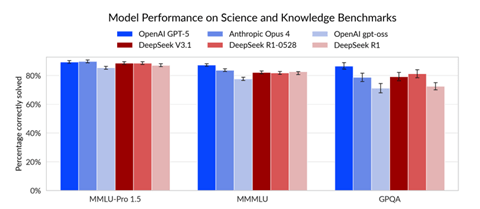

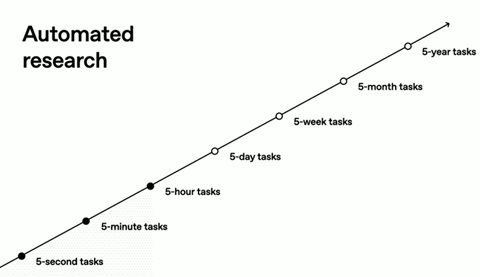

OpenAIはAGIという用語の代わりに「AI研究自動化(Automated AI Research)」を使い、人間レベルの研究エージェントがAGIに匹敵すると説明する。更に、このエージェントが2028年3月にリリースされるとピンポイントでスケジュールを示した。このゴールを達成するためにはアルゴリズムのブレークスルーに加え、大規模なデータセンタが必要になる。AGIは思考時間を長くすることで高度なタスクを実行する。これは「Inference Computing」と呼ばれ、長時間にわたり思考することで機能が向上する。 (下のグラフ、現在、思考時間は5時間程度であるが、これが5日・5週間・5か月・5年に伸びる。) 思考時間が延びるにつれGPUの稼働時間が長くなり、大規模なデータセンタが必要となる。

| 出典: OpenAI |