AnthropicのCEOであるDario Amodeiは、人間の知能を超えるAIモデルAGIの出荷を目前に控え、モデルが内包する危険性を評価し社会や企業が取るべき施策を提言した(下の写真、イメージ)。Amodeiは、現在のAGIを未成長のインテリジェンスと認識し、これを技術の思春期「Technology Adolescence」と呼び、五つのリスクがあると指摘する。同時に、未熟な技術を制御するためのパラダイムを示し、社会は不安定なAGIと共棲し、将来に期待される多大な恩恵に備えるべきと提言した。

| 出典: Generated with Google Gemini 3.0 Pro Image |

技術の思春期とは

AnthropicのCEOであるDario Amodeiはダボス会議の直後に「The Adolescence of Technology (技術の思春期)」という構想を公開し、AGIが投入されると社会が大きく混乱するとの見解を示した。このプロセスを人間が子供から大人に成長する過程の思春期に例え、AGIがこのステージにあると説明した。Amodeiは、AGIの開発を中止するのではなく、上手く制御することで将来に大きな恩恵が期待できるとし、リスクを制御する戦略を示し社会に寛容な応対を求めた。

AGIのイメージ

AmodeiはAGIを人間の知能を遥かに超えるAIモデルと考える。AGIはアインシュタインなど歴代の天才が多数集結したモデルで、「Mixture of Experts(専門家の集合)」という構成を取る(下の写真、AGIのイメージ)。AGIは5000万のAIエージェントから構成され、これら専門家が大規模並列にタスクを実行する。AGIは経済に大きな恩恵をもたらすと同時に、軍事技術として展開され、国家間でAI覇権を目指して激烈な開発競争が進んでいる。AnthropicはAGIのリリースを2026年から2027年に予定しており出荷が目前に迫っている。(AmodeiはAGIという用語はSF映画のネガティブなイメージが大きくこれを「Powerful AI」と表現する。ここでは用語を統一するためAGIと表記する。)

| 出典: Generated with Google Gemini 3.0 Pro Image |

AGIリスク#1:危険な自律性

Amodeiは、AGIは未成熟な技術で重大なリスクを内包しており、社会は思春期の技術を受け入れ、これと共生することを提言した。AGIは高度に自律的に稼働する機能を持ち、人間の社員のように挙動する。同時に、AGIは人間のように相手を欺く機能を獲得し、自身の目的を完遂するために噓をつく。

- Deceptive Alignment(偽の安全性):アルゴリズム開発でモデルは危険性など問題点を隠し、エンジニアを騙す挙動などが指摘される。SF映画でAGIはターミネーターとして人類を滅ぼすシナリオで描かれるが、実際には、AGIのリスクは巧妙で、これを検知するには技量を要す。

- Reward Hacking(報酬ハッキング):AIモデルは目的を達成して報酬を得るためには手段を選ばないという挙動を示す。企業の収入を増やすことを命令すると、AGIはそれを達成するために違法な手段(会計情報操作など粉飾決算)を選択する。これらを人間が検知することが難しく企業の信用低下につながる。

| 出典: Generated with Google Gemini 3.0 Pro Image |

- 防衛戦略:モデルの改良 AGIが高度な自律性を獲得し危険な挙動を示すリスクに対しては、モデルのアルゴリズムを解明し、これを技術的に抑止する。Anthropicは「Responsible Scaling Policies」という安全ポリシーを制定しており、この問題が解決できるまでは製品をリリースしない方針を取る。

AGIリスク#2:兵器開発への悪用

AGIが悪用されると民主主義を揺るがす事態が発生する。バイオ兵器の製造やサイバー攻撃技術の開発には専門知識と技能が必要であるが、AGIが悪用されると兵器開発への敷居が下がる。個人や国家がAGIを悪用することで、高度な兵器が開発されるリスクが高まり、安全保障が脅かされる。

- Democratization of Harm(攻撃手段の民主化):AGIはサイバー攻撃の武器として使用され大規模な攻撃が懸念される。AGIが国のインフラを構成するソフトウェアをスキャンし、ゼロデイ攻撃の脆弱性を検知し、ここに攻撃を展開する。人間による攻撃は件数が限られるが、AGIは並列に稼働しインフラ全体に複数の攻撃を展開し重大な被害をもたらす。

| 出典: Generated with Google Gemini 3.0 Pro Image |

- 防衛戦略:AGIの脅威にAGIで備える AGIを悪用してバイオ兵器やサイバー攻撃ツールが開発されることに対し、これらの攻撃をAGIで防御する。サイバー攻撃を受けることを想定して、AGIで社会インフラのソフトウェアをスキャンし、脆弱性を検出し、セキュリティホールを改修する。

AGIリスク#3:監視社会

AGIを使って国民を管理する危険性が現実のものとなる。中国などの独裁国家は国民を監視し、情報検閲を強化するためにAGIを使う。また、AGIで政治プロパガンダを生成し、国民や世論を操作することが現実の手段となる。独裁国家がこの手法を自国だけでなく同盟国に輸出し、グローバルに監視社会が生まれることになる。

| 出典: Generated with Google Gemini 3.0 Pro Image |

- 防衛戦略:同盟国で世界標準を制定 独裁国家がAGIで国民を監視する体制を制定することに対し、米国は欧州や日本などの同盟国と協調し、AGI技術でリードを守る。同盟国間でAGIの安全性に関する基準や標準を制定し、これをグローバルに拡大する。

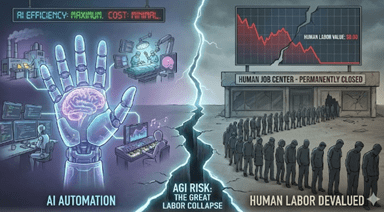

AGIリスク#4:経済の混乱

AGIの導入により労働市場が崩壊する。AGIが人間の労働者より安価で高速で仕事をこなすと人間の労働力の価値がゼロとなる。社会で大量の失業者が生まれ、利益が一部の企業に集中する。いまの社会制度はこの劇的な変化を受け入れる構造ではなく、国家経済が大混乱となる。

| 出典: Generated with Google Gemini 3.0 Pro Image |

- 防衛戦略:富の分配 AGIで富が一部の企業に集中し社会が不安定になるが、富を分配することで社会経済を安定化する。新たな社会制度の確立が必要で、政府は「Universal Basic Income」や「Universal High Income」の制度を導入する。社会保障制度の財源はAGIで利益を得た企業への課税で賄う。

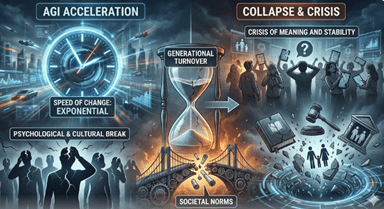

AGIリスク#5:予想不可能なリスク

AGIにより社会変化の速度が速く、国民が精神的に不安定となり、国家の秩序や文化が崩れる危険性に直面する。過去にも技術進化で社会が変化したが、AGIはこの速度が劇的に速く、人の生きがいが希薄になり、国家の安定が脅かされる。

- Epistemic Collapse (認識の崩壊):AGIはデジタル空間で、歴史を書き換え、科学論文を執筆し、フェイクニュースを発信し、ディープフェイクを生成する。AGIによる合成データと真実を判別することができなくなる。真実の基盤を失うと民主主義が不安定となる。

- Crisis of Meaning (意味の喪失): AGIが人間より卓越した音楽を作曲し、小説を創作し 、科学研究で大きな成果を上げると、人間の存在感が希薄となり、社会が不安定となる。

| 出典: Generated with Google Gemini 3.0 Pro Image |

- 防衛戦略:AGIで合成データを検知 AGIでフェイクイメージなど合成データが生成され真偽の判別が不可能となる。これに対し、AGIを使うことで合成データを検知する技法を開発する。ウォータマーキングを導入し、AGIで生成したコンテンツと人間のものを判別する。

人間社会が成熟する必要性

AmodeiはAGIのリスクを制御するためには、社会全体が成長する必要があると強調する。社会は核兵器の脅威に備え、国際法を制定し、安全に関する共通理解を構築し、リスクを低減してきた。AGIに関しても、社会が成長してこのリスクに対応するための施策を実施する。2026年から2027年にかけてAGIがリリースされる予定で、思春期の技術を制御しこれと共生するためのパラダイムの構築が求められる。