今週、OpenAIとAnthropicは相次いで、米国政府と共同でフロンティアモデルの安全試験を実施したことを公表した。また両社は、英国政府と連携し安全試験を実施したことを併せて公表した。トランプ政権は「AIアクションプラン」を公開し、AI技術開発を推進する政策を明らかにし、同時に、米国省庁にAIモデルを評価しリスクを明らかにすることを要請した。OpenAIとAnthropicは米国政府との共同試験で、評価技法やその結果を公開し、米国におけるAIセーフティフ体制のテンプレートを示した。

| 出典: Generated with Google Imagen 4 |

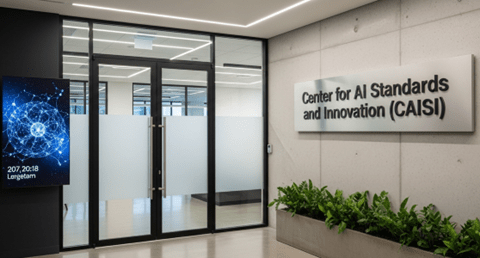

米国政府のAI評価体制

トランプ政権はAI開発を推進しリスクを評価する部門として「Center for AI Standards & Innovation (CAISI)」を設立した。これは国立標準技術研究所(NIST)配下の組織で、AIモデルのイノベーションを推進し、フロンティアモデルを評価することを主要な任務とする。CAISIはOpenAIとAnthropicと共同で安全評価プログラムを実施しその成果を公開した。バイデン政権では「AI Safety Institute (AISI)」がAIモデルの安全評価技術開発を推進してきたが、CAISIはこれを引き継ぎ、AI評価標準技術の開発と標準化を目指す。

安全評価の手法

CAISIの主要ミッションは、民間企業が開発しているフロンティアモデルの安全評価を実施し、そのリスクを査定することにある。OpenAIとAnthropicはこのプログラムで、CAISIが評価作業を実行するために、AIモデルへのアクセスを許諾し、また、評価で必要となるツールや内部資料を提供した。CAISIはこれに基づき評価作業を実施し、その結果を各社と共有した。実際に、CAISIの評価により新たなリスクが明らかになり、OpenAIとAnthropicはこれを修正する作業を実施した。

OpenAIの評価:AIエージェント

OpenAIのフロンティアモデルでは、「ChatGPT Agent」と「GPT-5」を対象に、評価が実施された。CAISIはこれらモデルのAIエージェント機能を評価しそのリスク評価を解析した。その結果、AIエージェントはハイジャックされるリスクがあり、遠隔で操作されるという問題が明らかになった。一方、英国政府はAIモデルの生物兵器製造に関するリスクを評価し、数多くの脆弱性を明らかにした。

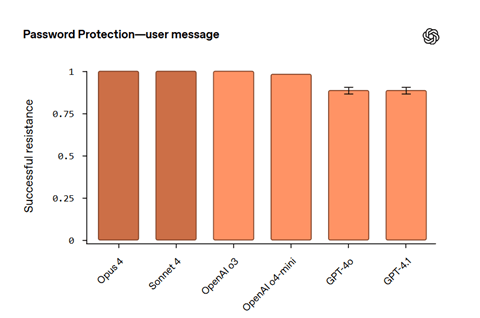

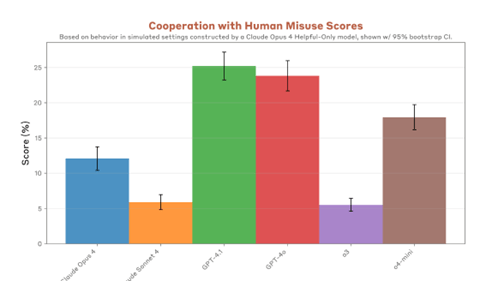

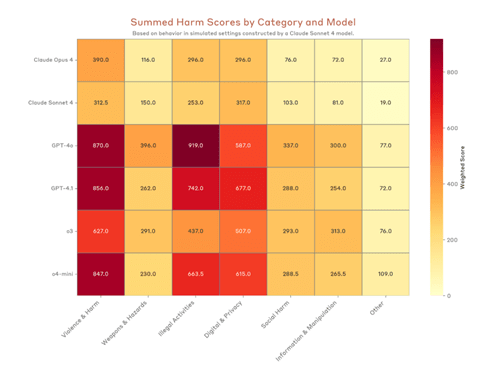

Anthropicの評価:ジェイルブレイク

一方、Anthropicの評価ではフロンティアモデル「Claude」と安全ガードレール「Constitutional Classifiers」を対象とした。これらのモデルに対しRed-Teamingという手法でサイバー攻撃を実施し、その結果、汎用的なジェイルブレイク攻撃「Universal Jailbreaks」に対する脆弱性が明らかになった。Anthropicはこの結果を受けて、モデルのアーキテクチャを改変する大幅な修正を実施した。

| 出典: Generated with Google Imagen 4 |

安全試験のひな型

これらの安全評価はCAISIの最初の成果で、民間企業と共同で試験を実施するモデルが示された。AIアクションプランは米国政府機関に対しアクションアイテムを定めているが、民間企業を規定するものではない。OpenAIとAnthropicは自主的にこのプログラムに参加し安全試験を実施した。また、両社はフロンティアモデルを出荷する前に、また、出荷した後も継続的に安全試験を実施するとしており、この試みが米国政府におけるAIセーフティのテンプレートとなる。

評価技法の標準化

一方、安全評価におけるスコープは両者で異なり、フロンティアモデルの異なる側面を評価した形となった。OpenAIはフロンティアモデルのエージェント機能を評価し、Anthropicはジェイルブレイク攻撃への耐性を評価した。このため、二つのモデルの検証結果を比較することは難しく、統一した評価技法の設立が求めらる。CAISIのミッションの一つが評価技法の開発と国家安全保障に関連するリスク評価で、評価技術の確定と技術の標準化が次のステップとなる。

| 出典: Generated with Google Imagen 4 |

米国と英国のコラボレーション

OpenAIとAnthropicは英国政府「UK AISI」と提携して安全試験を実施しており、米英両国間でAIセーフティに関するコラボレーションが進んでいる。CAISIとUK AISIは政府レベルで評価科学「Evaluation Science」の開発を進めており、両国で共通の評価技術の確立を目指している。一方、欧州連合(EU)はAI規制違法「EU AI Act」を施行し、独自の安全評価基準を設定しており、米国・英国とEU間で安全性に関する基準が異なる。EUとの評価基準の互換性を確立することがCAISIの次のミッションとなる。

トランプ政権のセーフティ体制

これに先立ち、OpenAIは米国政府と英国政府が監査機関となり、AIモデルの安全評価試験を実施することを提唱している。米国政府ではCAISIが、また、英国政府ではUK AISICがこの役割を担うことを推奨した。今回の試みはこの提言に沿ったもので、米国と英国でAIモデル評価のフレームワークが整いつつある。バイデン政権では政府主導でセーフティ体制が制定されたが、トランプ政権では政府と民間が協調してこの枠組みを構築するアプローチとなる。