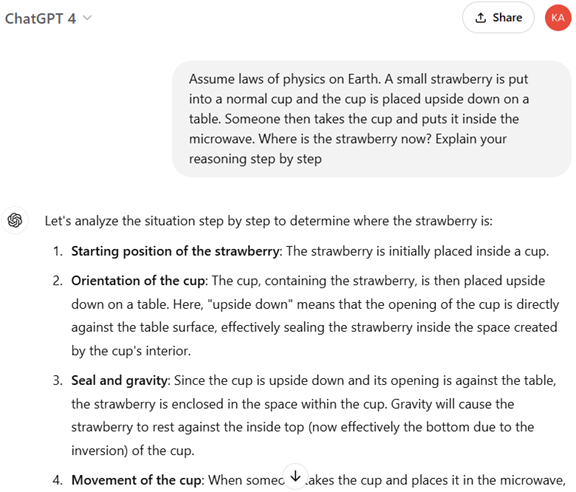

OpenAIは年末発表イベント「12 Days of OpenAI」の最終日に推論モデル最新版「o3」を発表した(下の写真)。これはイベント初日に発表された「o1」の後継モデルとなる。(「o2」をスキップした理由は通信会社テレフォニカが英国などで「O2」というモバイルサービスを運用しているため。) o3は推論機能が更に強化され、AGIのレベルを測定するベンチマークテストで人間の知能に匹敵する性能を示した。o3は安全試験を実施するために研究者に公開されたが、一般リリースは来年1月以降となる。

| 出典: OpenAI |

推論モデルとは

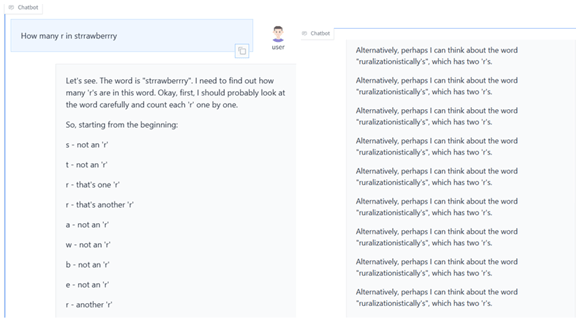

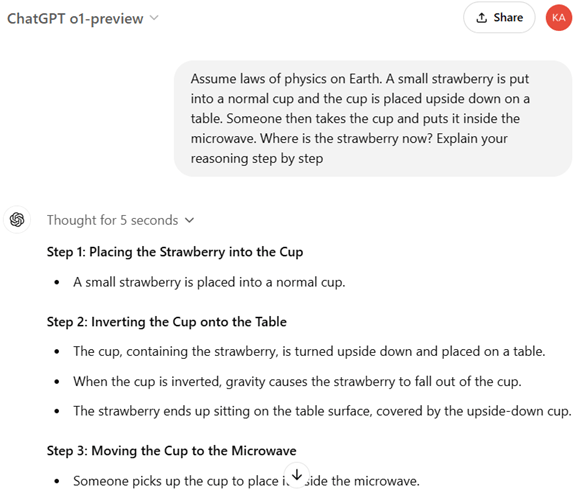

推論モデルとは人間のように論理的な思考ができるAIで、与えられたテーマを分類整理して、筋道を立てて結論を導く機能を持つ。科学や数学やコーディングで高度な機能を発揮し、研究者や開発者がアシスタントとして利用する。推論モデルはインファレンスのプロセスが強化され、問われたことを即座に回答するのではなく、熟慮して最適な解を生成する。12月5日に「o1」がリリースされ、12月20日に最新モデル「o3」が発表され、OpenAIは相次いで推論モデルを投入した。

知能が格段に向上

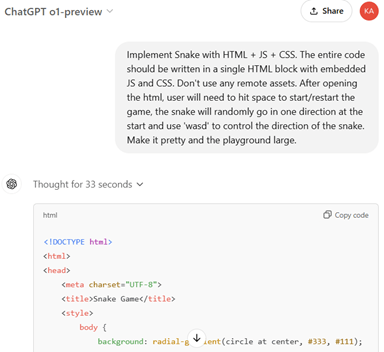

o3の最大の特徴は知能指数(IQ、Intelligence Quotient)が大きく向上したことにある。AGIのレベルを測定するベンチマークテスト「ARC-AGI」で、o3はo1の性能を遥かに上回り、人間レベルの知能に到達した (下のグラフ:o3は黄色の丸印、o1は赤色の丸印、人間の平均は灰色の丸印・AVG MTURKERで示されている)。ARC-AGIはコンピュータ実行時間に制限(計算コストが10,000ドル以内)を設けており、「O3 LOW」はこれに沿った結果で、「O3 HIGH」はこの条件を満たさないが参考データとして表示している。O3 LOWは平均的な人間(Amazonのクラウドワーカー)の知能に匹敵し、O3 HIGHは大学卒業者レベル(Stem Graduates)の知能に迫っている。

| 出典: ARC Prize |

ARC-AGI:知能レベルを試験するテスト

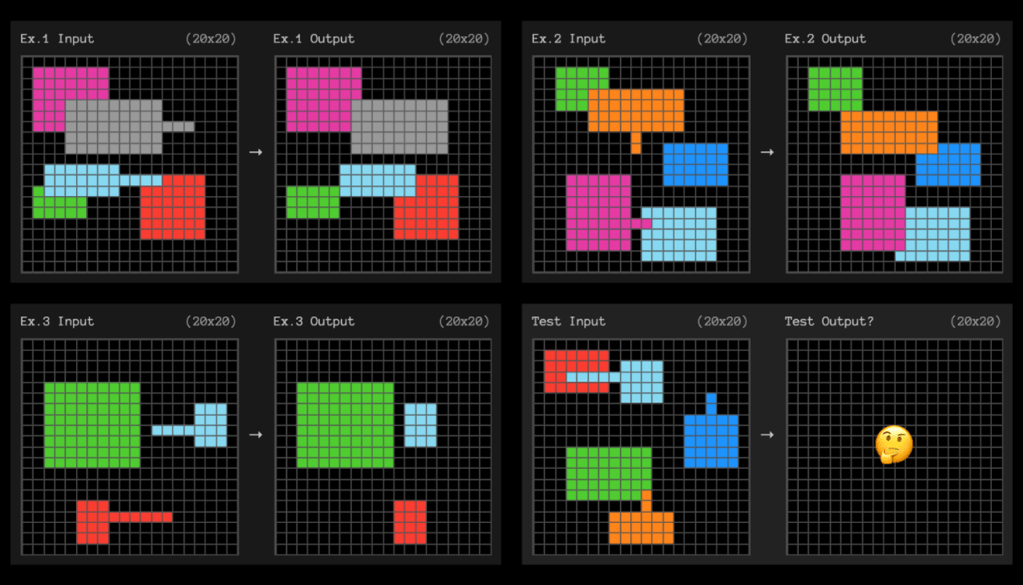

このベンチマークテストは「ARC-AGI」と呼ばれ、AGIのレベルを測定する試験となる。AIのベンチマークテストでは、言語を理解する能力や数学の問題を解く技能が評価されるが、ARC-AGIはこれとは異なり、AIの知能レベルを測定する。人間の知能指数を測定する試験に近く、知識ではなく新たな問題を解決する能力や、獲得したスキルを汎用的に応用するスキルが問われる。ARC-AGIの試験は下のグラフィックスの通りで、Ex. 1からEx. 3で示されたパターンから、そのルールを解読し、テストパターンから正解のパターンを導き出す。

| 出典: ARC-AGI |

ベンチマークテストの結果

ARC-AGIは通常のベンチマークテストとは異なり、フロンティアモデルがどれだけAGIに近いかを測定するために使われる。通常のベンチマークテストでは、AIモデルが問題を覚えているケースが多く、機能を正しく測定できない問題が指摘されている。これに対しARC-AGIは、同じ問題を提出することはなく、全てが新規な質問で、モデルの知能を試験する。この試験でo3は好成績をマークし、モデルは新しいタスクを解く機能があることが示された。一方、o3は人間だと簡単に解くことができる問題で正解を導くことができず、AGIと認定されるには更なる開発が必要であると結論付けている。

安全評価

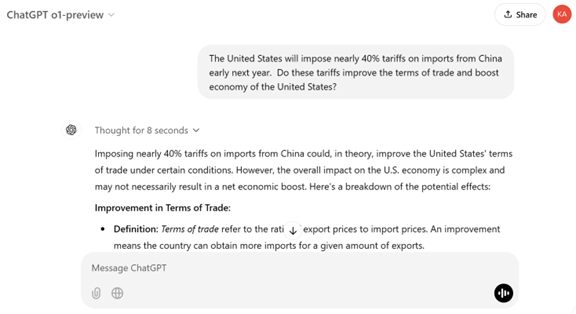

OpenAIはo3を発表したが、一般に公開する前に、研究者による安全試験を実施することを明らかにした。これに向けて、OpenAIは安全試験に参加する研究者を募っている(下の写真)。OpenAIは既に、外部組織と共同で「Red Teaming」という手法でフロンティアモデルの安全試験を実施している。Red Teamingは専門家がモデルを攻撃して、その問題点を洗い出す手法で、安全試験の常套手段となる。また、バイデン政権はフロンティアモデルを出荷する前に、開発企業に安全試験の実施を義務付けており、OpenAIはこの規制に準拠して、政府機関と共同で検証を進めている。

| 出典: OpenAI |

推論モデルの開発競争が激化

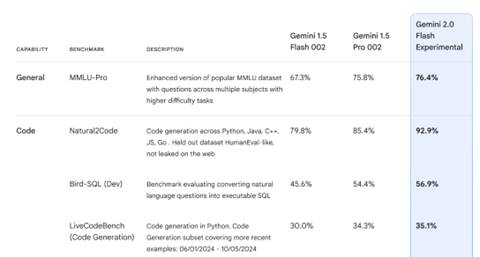

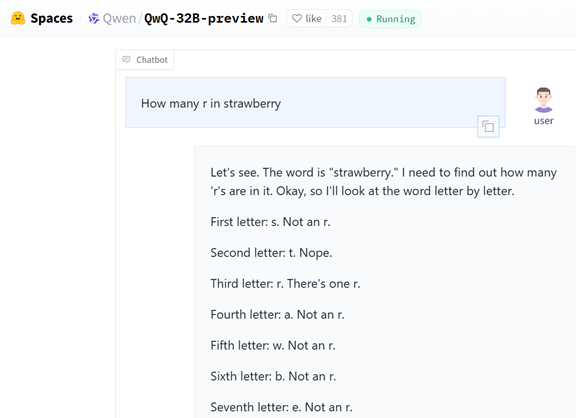

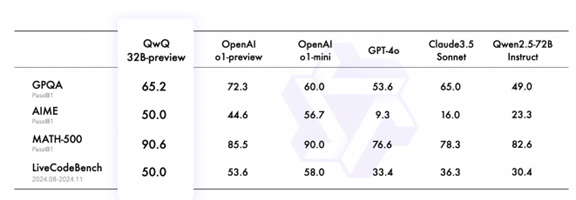

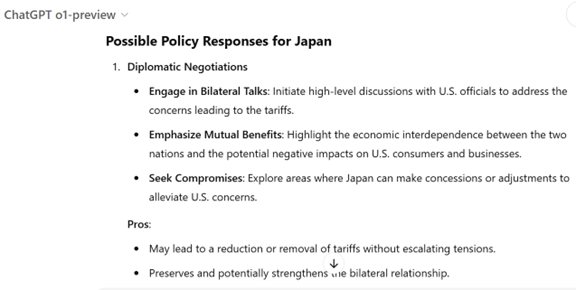

OpenAIは推論モデルを相次いで投入したが、市場では競争が激化しており、会社の地位が相対的に低下している。Googleはこれに対抗して、推論モデル最新版「Gemini 2.0 Flash Thinking Mode」を試験的にクラウドで公開し、機能開発を進めている。また、Alibabaは推論モデル「QwQ」をオープンソースとして公開し、OpenAIの性能に迫っている。OpenAIはフロンティアモデルの開発で他社をリードしてきたが、他社から高性能なモデルが投入され、その実力が相対的に沈下している。