カリフォルニア州政府は次世代AI「フロンティアモデル」の開発と運用に関し、規制法の導入を進めている。この法案は「Safe and Secure Innovation for Frontier Artificial Intelligence Models Act」と呼ばれ、開発企業にAIモデルが安全であることを検証し、これを報告することを義務付ける。また、AIモデルが第三者により改造され、それが社会に危害を及ぼした場合でも開発企業の責任が問われる。厳しいAI規制であるが、予想に反し州議会上院を通過し、法案が成立する公算が強まった。連邦議会ではAI規制法が制定される機運は低いが、米国は地方政府がAIの安全な開発や運用を規定する方向に進んでいる。

| 出典: California.com |

カリフォルニア州議会上院で可決

カリフォルニア州のAI規制法案は上院で賛成多数で可決され、AI業界に波紋が広がっている。予想を覆して州議会上院を通過し、8月には下院で審議され、AI規制法が成立する公算が強まった。カリフォルニア州はAI開発の拠点で、ハイテク企業が集結し、先進技術を開発している。カリフォルニア州で厳しいAI規制法が可決されると、その波紋は大きく、他の州がこれに追随する可能性が高まる。米国は連邦政府でAI規制法の制定は愛踏み状態であるが、これに代わり州政府が独自の規制法を施行する方向に進んでいる。

AI規制法案の概要

米国連邦議会はAI規制法を制定する機運は薄く、国家レベルで統一した指針が示されることは期待できない。このため、カリフォルニア州は独自のAI規制法案を策定し、AIの安全対策を進めている。この法案は次世代の生成AI「フロンティアモデル」を対象としており、高度な機能を持つAIを安全に開発・運用することを目標とする。バイデン政権は大統領令で、フロンティアモデルの安全試験を開発企業に求めているが、カリフォルニア州の規制法案はこれより厳しい内容となっている。

極めて厳しい内容

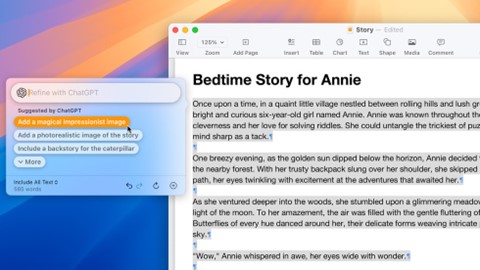

AI規制法案は、開発企業にAIモデルを試験し、安全を確認し、その結果を州政府のAI監査室「Frontier Model Division」に報告することを求めている。また、AIモデルが悪用されることを防ぐため、セーフガードの導入を求めている。更に、開発したAIモデルが第三者により改造され、これが悪用された場合には、この使用を停止させる措置を求めている。フロンティアモデル開発企業が下流のAIアプリケーションまで責任を問われる構造で、極めて厳しい義務が課される。因みに、「AI監査室」とは新設される州政府の組織で、AIモデルの運用監視や安全監査を任務とする。

| 出典: Adobe Stock |

スタートアップ企業へのインパクト

AI規制法案はスタートアップ企業に重大な影響を与えることが予想される。Googleなど大企業は、既にAIモデルの安全管理を専門とする部署を設け、ここで安全対策を進めている。しかし、スタートアップ企業は技術開発にリソースを集約し、安全試験を包括的に実施する余裕はない。このAI規制法案が成立すると、スタートアップ企業はカリフォルニア州で事業を展開することが難しくなる。

オープンソースにとって厳しい内容

また、オープンソース企業はAI規制法案が可決されると、重い責務を負うことになる。AI規制法案は、ファウンデーションモデルが第三者により改造され、それが悪用され、社会に危害を及ぼした場合は、その責任はAI開発企業にあるとしている。オープンソースは、下流の利用者がモデルを再教育して、特定のアプリケーションに特化したモデルを生成するために使われる。しかし、敵対国や攻撃集団がオープンソースを改造し、それをサイバー攻撃などで使った場合は、AI開発企業がこの責任を負うことになる。

Metaの反論

多くの企業がオープンソースを開発しており、AI規制法案のインパクトは多岐に及ぶ。Metaはフロンティアモデルをオープンソースとして公開しており、重大な責務を負うことになる。このため、MetaはXにコメントを掲載し、この規制法案はカリフォルニア州の利益に反すると批判した(下の写真)。AI規制法案が可決されると、多くのスタートアップ企業がカリフォルニアを離れると警告している。また、大企業も生成AI部門を他州に移転し、カリフォルニア州の経済への打撃が広がると警鐘を鳴らしている。

| 出典: Arun Rao @ X |

AI規制法の背景情報

AI規制法案はカリフォルニア州上院議員Scott Wiener(下の写真)により導入され、予想に反して、上院で賛成多数で可決された。この法案は非営利団体「Center for AI Safety (CAIS)」が支援しており、法案可決に関しこの団体の影響力が大きい。CAISはサンフランシスコに拠点を置き、AIのリスクを低減し安全性を担保するための活動を展開している。この代表者がDan Hendrycksで、人間レベルの知能・AGIの危険性に関する研究を進めており、AI規制に関し大きな影響力を持つ。

| 出典: Scott Wiener |

州議会下院での審議が始まる

Scott WienerはインタビューでAI規制法案のコンセプトについて説明し社会の理解を求めている。WienerはAI技術が急速に進化する中、これを適切に管理する規制法が必要であり、「Light Touch(軽量)」の規制を導入すると述べている。技術進化を後押しするが、安全を担保するために、最小限の規制が必要であるとしている。これからカリフォルニア州議会下院でAI規制法案の審議が始まり、法案を修正して、最終判断が下されることになる。どのような展開になるか予測は難しいが、識者の多くは可決される公算が高いとみている。