Googleは5月14日、開発者会議「Google I/O」で生成AI「Gemini」の最新情報を公開した。基調講演でSundar Pichaiは「Geminiの時代が到来した」と述べ、AIをビジネスの基盤とし、それを検索エンジンなど主要サービスに統合。また、高速モデル「Gemini Flash」がリリースされ、これを基盤とするAIアシスタントの構想が示された。今年のGoogle I/OはGemini一色の開発者会議となった。

| 出典: Google |

Geminiの機能アップ

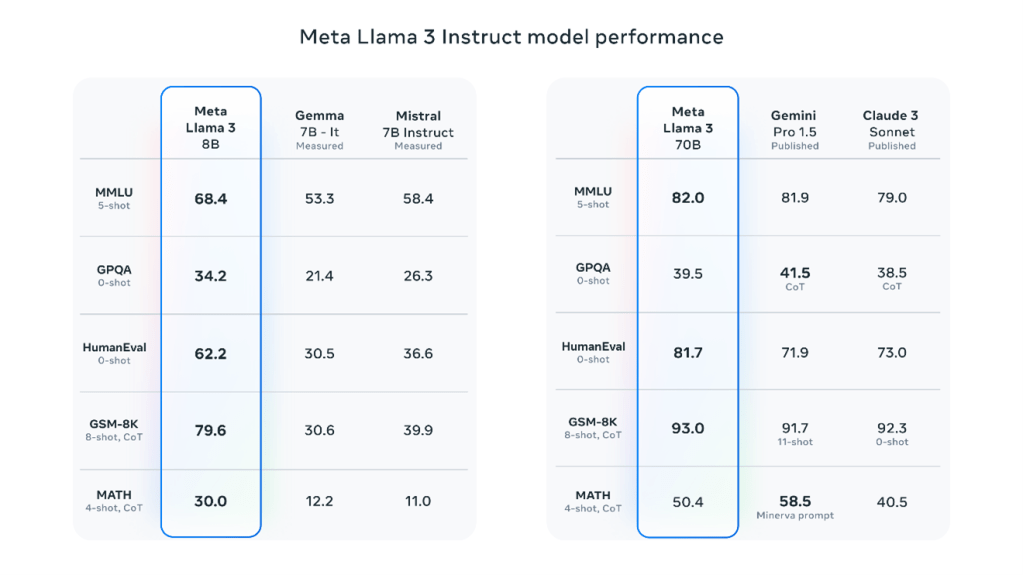

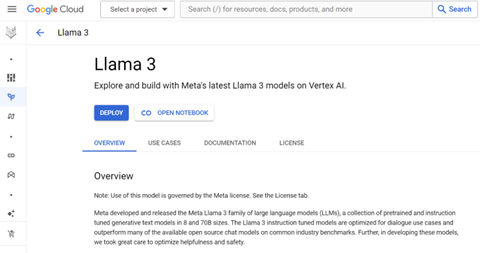

Googleは昨年12月、フロンティアモデル「Gemini」を投入した。更に、今年2月には高速モデル「Gemini Pro 1.5」を投入し、業界トップの性能をマークした。Geminiの特徴はコンテクスト・ウインドウ(入力できるデータサイズ)が大きいことで、最大で100万トークン(言葉の単位)を処理できる。開発者会議ではこれを拡大し、200万トークンをサポートすることを明らかにした。また、Googleはモデルの処理速度を向上した「Gemini Flash」を投入した(下の写真)。「Gemini Pro」が大規模モデルで機能性を追求するが、「Gemini 1.5 Flash」はスリムなモデルで高速処理を実現した。会話などリアルタイムの応答が求められるアプリケーションで使われる。

| 出典: Google |

検索エンジンをGeminiで強化

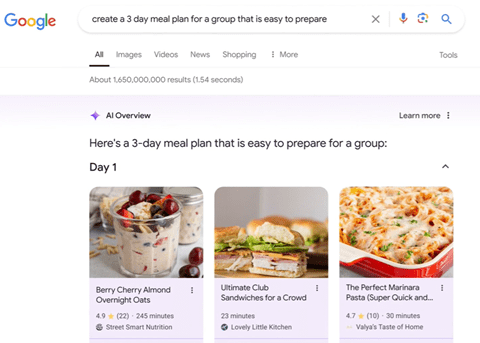

GoogleはGeminiを検索エンジンに組み込んだ検索サービス「Search Generative Experience」を試験的に運用してきた。Googleはこの検索サービスを強化した「AI Overviews」を開発し、来週からアメリカで展開する。AI Overviewsとは、ズバリ回答を生成する機能で、複雑な質問に対し、Geminiが情報を統合し、回答を生成する。例えば、グループで共同生活する際に、三日間の食事のメニューを尋ねると、検索エンジンはこれをテーブル形式に纏めて回答する(下の写真)。

| 出典: Google |

ビデオでの質問に回答

質問をテキストではなくビデオで尋ねると、検索エンジンはこれに回答する。例えば、旧式のレコードプレーヤーのアームが動かなくなった際は、それをビデオで撮影し(下の写真右側)、検索エンジンに入力し、対処法を尋ねるなどの使い方ができる(左側)。

| 出典: Google |

マルチモダル:「Imagen 3」と「Veo」

Geminiの特徴はネイティブのマルチモダル構造を取ることで、テキストの他にイメージやビデオやボイスを入出力することができる。単一のネットワークでマルチモダルを処理するアーキテクチャとなる。Googleはテキストからビデオを生成するモデル「Veo」を投入した。Veoはプロンプトを正確に理解し高解像度(1080p)の映像を生成する。Veoはクリエータがビデオを制作するすることを目的に開発され、映画のシーンのような映像を生成する。(下の写真:「香港の街並みを走り抜けるクルマ」。URL:https://www.youtube.com/watch?v=diqmZs1aD1g)

| 出典: Google |

イメージ生成モデルの強化

テキストからイメージを生成するモデルの最新版「Imagen 3」がリリースされた。このモデルは解像度が向上し、写真撮影したような極めてリアルなイメージを生成する。また、プロンプトを理解する能力が向上し、指示された意図を正確に把握してイメージを創り上げる。(下の写真:「渓谷を流れる川と緑の木々に覆われた山々」)

| 出典: Google |

ワークスペースの機能拡張

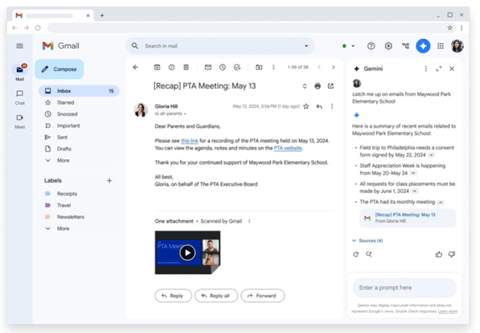

Googleはオフィス製品「Workspace」を提供している。WorkspaceはGmail、Docs、Sheets、Slidesで構成され、ここにGeminiを統合し、生産性を向上してきた。これは「Gemini for Google Workspace」と呼ばれ、ここに最新モデル「Gemini Pro 1.5」が統合され、機能が大きく拡張した。これにより、Gmailは受信したメールの要約を生成する(下の写真)。サイドパネルで受信したメールを要約するよう指示すると、Geminiはメール毎にその内容を簡潔にまとめる(右側のカラム)。これは、小学校のPTA会議に関するメール4通の要約を生成した事例で、メール本文を読まないで会議の内容を理解できる。

| 出典: Google |

未来のAIアシスタント:Project Astra

GoogleはAIアシスタントのコンセプト「Project Astra」を初公開した。AIアシスタントはGemini 1.5 Flashに構築されたモデルで、人間のように視覚を持ち、言葉の指示に従ってタスクを実行する。AIアシスタントは現実社会で周囲のオブジェクトを理解し、問われたことに対しリアルタイムで回答する。この処理を実行するためには、高速のイメージ処理と会話機能が求められ、Gemini Flashがこの要件を実現する。(下の写真:スマホカメラでオフィス内部をスキャンし、「音を発生するデバイスを見つけたら知らせて」と指示すると、AIアシスタントは「スピーカーを見つけた」と回答。)

| 出典: Google |

Geminiの時代

今年のGoogle I/OはAIフロンティアモデル「Gemini」を主軸とする開発者会議となった。Geminiはチャットボットではなく、Google Cloudで社会のインフラを支える存在となる。また、検索エンジンにGeminiが組み込まれ、生成AI検索が標準となり、Googleのビジネスが激変する。更に、GoogleはGemini FlashでAIアシスタントのコンセプトを示し、AIがデジタルからリアルの社会に降りてきて、人間レベルの知能を持つ「AGI」に繋がる構想を明らかにした。