OpenAIのCEOであるSam Altmanは、AIが爆発的に進化する「シンギュラリティ(Singularity)」の圏内に突入したとの見解を示した。シンギュラリティは知能の爆発とも呼ばれ、AIが暴走し、人類が滅びるストーリーとして描かれる。しかし、Altmanは、AIを人間の価値に沿ったモデルにし、また、AIを一部の人物や企業や国家が独占することなく、人々がこの恩恵を公平に享受できれば、豊かな社会を実現できるとのビジョンを示した。世界は後戻りできないポイントを超え、人類が滅びるか繫栄するかの岐路に直面している。

| 出典: Generated with OpenAI o3 |

シンギュラリティとは

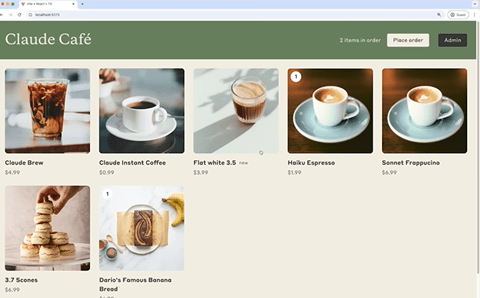

「シンギュラリティ(Singularity)」とは技術的な特異点を示す用語となる。AIにおける特異点とは、技術が指数関数的に成長し、人間の知能を大幅に凌駕するポイントを指す。シンギュラリティは二種類あり、「ハード・シンギュラリティ」と「ソフト・シンギュラリティ」に分類される。前者は、AIが爆発的に進化し、人間が制御することができず、AIが暴走する社会となる。これは「知能の爆発」とも呼ばれ、SF映画で描かれるシナリオとなる。一方、後者は、AIの技術は急速に進化するが、人間がAIを制御する技術を開発することで、AIの恩恵を享受できる社会が生まれるとのシナリオとなる(下の写真、ソフト・シンギュラリティのイメージ)。

| 出典: Generated with OpenAI o3 |

穏やかなシンギュラリティ

OpenAIのCEOであるSam AltmanはAIに関するビジョンを発表し、社会は既にソフト・シンギュラリティの圏内に入っているとの見解を示した。Altmanはソフト・シンギュラリティを「穏やかなシンギュラリティ(Gentle Singularity)」と表現し、AIの恩恵を享受できる豊かな社会が生まれると予測する。世界はイベントホライゾン(Event Horizon)を超え、もう後戻りはできず、シンギュラリティに向かって進んでいる。(イベントホライゾンとはブラックホールで使われる用語で、重力が大きく光でも脱出することができない領域を指す。)

シンギュラリティのロードマップ

Altmanはシンギュラリティに向かったロードマップを示し、AIが生み出す新しい社会観を解説した。

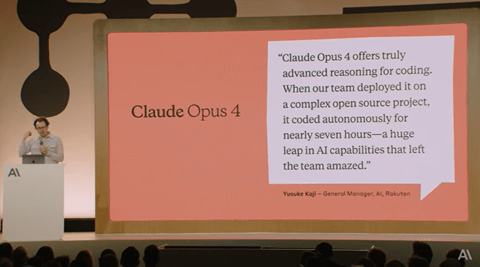

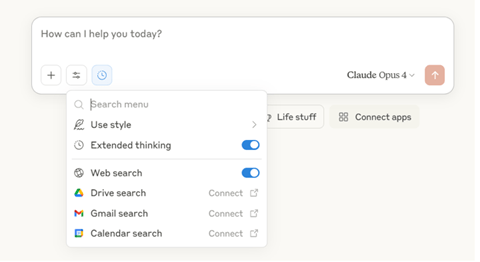

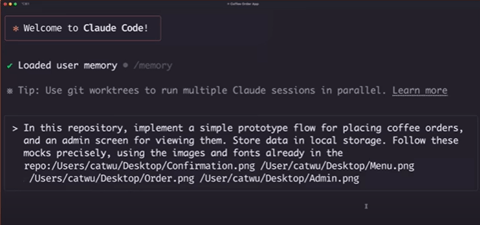

- 2025年:エージェントが人間に代わり仕事やタスクを実行する。例えば、エージェントがエンジニアに代わりプログラムを開発する。

- 2026年:AIが科学技術において新たな論理を生み出す。現行のAIは人間が生み出した論理をベースに新技術を生み出すが、新世代のAIは人間に代わり新しい論理を生み出す。

- 2027年:ロボティックスが急進しロボットがロボットを製造する(下の写真)。ハードウェア開発でもシンギュラリティが生まれる。

- 2030年代:知能とエネルギーが無尽蔵な社会となる。AIのコストが劇的に下がり、電気料金程度となり、知能を豊富に使うことができる。

| 出典: Generated with OpenAI o3 |

科学技術の進化が加速

既にAIにより大きな恩恵を享受しているが、これからAIにより重大な発見が相次ぎ、社会が大きく変化する。今はAIを医療技術に応用し、メディカルイメージングをAIで解析することで、がんを高精度に検知する。これからは、AIで医療技術の開発期間が劇的に短縮され、がん治療薬が登場する。また、現在はAIがエンジニアに代わりプログラミングを実行するが、これからはAIがソフトウェア全体を開発し、AIが会社を設立しそれを運用する時代となる。

社会へのインパクト

高度なAIにより技術が急進し、社会に多大な恩恵をもたらすが、社会構造は大きく変わる。AIが人間に代わり仕事をするため、殆どの職がAIで置き換わることになる。一部の職種がAIに奪われるのではなく、殆どの職が無くなる。しかし、シンギュラリティ時代には新たな職種が生まれ、仕事に関する価値観が大きく変わる。社会や経済の変化は急で、人々はこれを理解し、新しい環境に適用できるまでには時間を要す。産業革命など、過去の事例が示すように、人々は長い年月を経て新し環境に適用していく。

新時代のAIに求めらること

AIが社会に恩恵をもたらすことを担保するためには、技術面と政策面で新たなメカニズムが求められる。技術面では「アラインメント(Alignment)」で、AIが人間の価値に沿って稼働するための技術の開発が求められる。高度なインテリジェンスを制御する技法の研究開発が重要なテーマとなる。政策面では、AIの恩恵が一部の人物や会社や国家に集中することなく、人々がこれを享受するための政策や枠組みが必要となる。

2035年の社会像

高度なインテリジェンスにより社会が大きく変わり、Altmanは2035年までに達成される技術を予測している。一つは、高エネルギー物理学の急速な進展で、核融合発電が現実のものとなる。これにより、クリーンなエネルギーが大量に生成され、地球温暖化の抑止に大きく貢献する。また、インプラントにより人間の頭脳がエンハンスされる。インプラントでは脳にチップを埋め込むが、物性物理学のブレークスルーで、大量のデータを送受信できるようになる。(下の写真、2030年代には人類が他の惑星への移住を始める。)

| 出典: Generated with OpenAI o3 |

シンギュラリティの議論

Altmanは、AIが爆発的に進化するシンギュラリティに突入したが、AIが人類を滅ぼすのではなく、知識とエネルギーが無尽蔵な豊かな社会が生み出されるとの見方を示した。市場では様々な意見があり、Altmanの予測はOpenAIのマーケティング戦略であるとの反応も少なくない。また、懐疑派は現行の技法を拡張してもシンギュラリティに到達できないとの考え方を示している。「穏やかなシンギュラリティ」を生み出せるのか、市場で議論が白熱している。