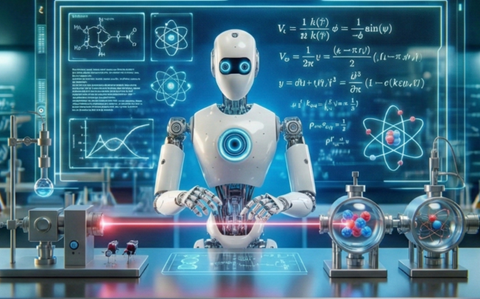

2026年はAIサイエンティストが研究所で人間に代わりバイオ医薬品などを開発する年となる。AIサイエンティストとは科学技術に特化したAIエージェントで、研究者に代わり新薬の開発などを実行する。AIサイエンティストは科学に関する膨大なデータを解析し、仮説を立案し、それを検証することで、地上に存在しない新たなたんぱく質や抗体などを生成する。トランプ政権はジェネシス・ミッションで、AIサイエンティストを戦略技術と位置付けており、連邦政府がこのプロジェクトを支援する。

| 出典: Generated with Google Nano Banana Pro |

AIサイエンティストとチャットボット

AIサイエンティストは最重要研究テーマで議論が白熱しハイプの状態が続いてきた。今年はこれがいよいよ技術として実装される年となる。AIサイエンティストはチャットボットとは機能も構造も大きく異なる。チャットボットは科学者の質問に回答し、アシスタントとして研究を支援する。これに対しAIサイエンティストは、与えられた研究テーマを人間の介在無く自律的に実行する。医薬品の開発では特定の機能を持つたんぱく質を創成するなど、人間の研究者レベルのタスクを実行する。

AIサイエンティストの機能

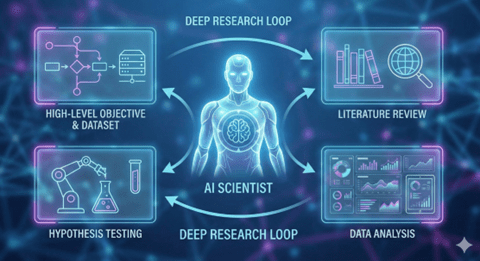

このように、AIサイエンティストは研究者として位置付けられる。人間がハイレベルな研究テーマを指示し関連するデータセットを提示すると、AIサイエンティストは独自で研究プロセスを展開する。具体的には、公開されている論文を読み研究の最先端情報を理解する。次に、提示されたデータセットを解析し、これらを統合して仮説を構築する。更に、構築した仮説を証明するために試験を実行する。

| 出典: Generated with Google Nano Banana Pro |

AIサイエンティストの性能

最先端のAIサイエンティストは人間の研究者が半年かかる作業を半日程度で実行する。研究を実行するためには膨大な数の論文を読む必要があるが、AIサイエンティストは1,000を超える論文を読みこれを理解し研究の最先端情報を把握する。これらをベースに仮説を立案し、これを検証するプロセスを実行する。実際には、仮説を検証するためのプログラムを生成し、これを実行することで推論が正しいことを裏付ける。AIサイエンティストは膨大な情報を解析するだけでなく、これを前提し新たな仮説を生み出し、これが正しいことを証明する機能を持つ。

AIサイエンティストの恩恵

AIサイエンティストは医療において大きな進化をもたらすと期待されている。ニューロサイエンスの分野では、脳の加齢のメカニズムを解明し、アルツハイマー型認知症の治療薬の開発で大きな成果が期待される。また、エネルギーの分野では、ペロブスカイト太陽電池(perovskite solar cells)を効率化する技法の開発で使われる。

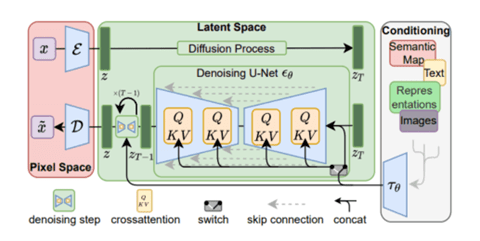

フロンティアモデルとの関係

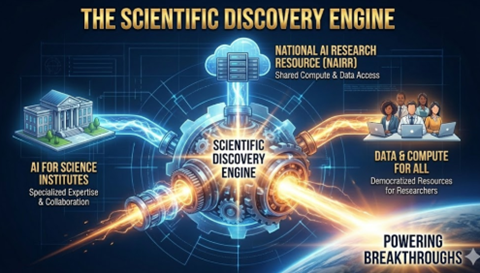

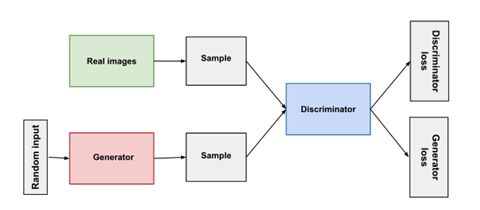

AI開発企業からOpenAI GPT-5.2やGoogle Gemini 3などフロンティアモデルがリリースされているが、これらが単体でAIサイエンティストを構築することはできない。AIサイエンティストの開発では「Structured World Model(構造的世界モデル)」というアーキテクチャがキーとなる。AIサイエンティストは複数のAIエージェントから構成され、Structured World Modelがこれらを管理運用するフレームワークとなる。このフレームワークの元で、論文を解析するAIエージェントや提示されたデータを解析するAIエージェントなどが稼働しており、エージェント間で情報を共有する制御や、長時間にわたりコヒーレントな処理を保証する仕組みなどが必須の機能となる。

AIサイエンティスト市場

ビッグテックやスタートアップがAIサイエンティストの開発を進めている。その代表がGoogleで、AIサイエンティスト「AI Co-scientist」を開発している。AI Co-scientistは、膨大な量のデータセットをベースに、物理学、バッテリー素材、核融合発電などの分野をターゲットに、自律的に研究を実行する。GoogleはAI Co-scientistを米国エネルギー省の国立研究所に納入し、科学技術研究に寄与することを計画している。トランプ政権のジェネシス・ミッションに沿って、国立研究所と共同でサイエンスの研究開発を加速する。

| 出典: Google |

研究所の自動化技術

AIサイエンティストはロボティックスと融合し、研究所のオペレーションを自動化する。これは「Self-Driving Labs (SDLabs)」と呼ばれ、AIサイエンティストが構築した仮説を、研究所においてロボットが実験を司り、人間に代わりこれを証明する。AIサイエンティストが研究所のロボットに、薬剤の混合や試験結果の検証などを指示し、AIとロボットのループで研究が進む。ジェネシス・ミッションではこの技法を「Robotics Labs」と呼び、この開発を重要アクション項目と定めている。

| 出典: World Economic Forum |

サイエンスのブレークスルー

AIモデルはブラックボックスでアルゴリズムの判定理由が不透明で、これがハルシネーションの原因となる。AIサイエンティストは研究成果の精度が厳しく問われ、生成した仮説を裏付けるデータが必須となる。AIサイエンティストは研究成果をRobotics Labsで検証し、根拠となる実験結果を示すことで、高精度な研究成果を生み出す。今年はAIサイエンティストで米国の科学技術研究が急進し、大きなブレークスルーが起こると期待される。