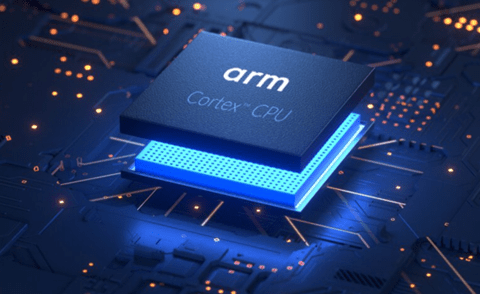

Armはプロセッサ開発会社でRISCベースのアーキテクチャを開発している。Armは主要プロセッサで採用され世界の標準技術となっている。Armベースのプロセッサはクラウドで使われ計算機インフラを支えている。Armはプラットフォームをデジタルからフィジカルに大転換すると発表した。これは「フィジカルAI」に事業をシフトすることを意味し、Armが自動運転車やロボットの頭脳を構成する。今年はArmを搭載したヒューマノイドが製品化され、ロボティックスの進化を陰で支える。

| 出典: Arm |

Armの会社概要と事業形態

Armはイギリス・ケンブリッジに拠点を置く企業でプロセッサと関連ソフトウェアを開発している。Armの名称はよく知られているが、その事業形態については理解が広がっていない。ArmはIntelなどとは異なり、プロセッサを製造販売するのではなく、プロセッサの知的財産 (Intellectual Property)をライセンスする形態を取る。知的財産とはプロセッサの設計図で、CPUコアの回路、プロセッサのアーキテクチャ(命令セット)、システム構成(チップに実装するときのインターフェイス)などで、企業はこれをベースに回路を最適化して独自の製品を開発する。AppleやQualcommやNvidiaなど主要企業がArmの知的財産をベースに独自プロセッサを開発しこれを販売している。

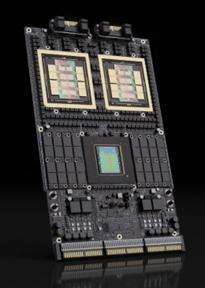

次世代GPUシステム

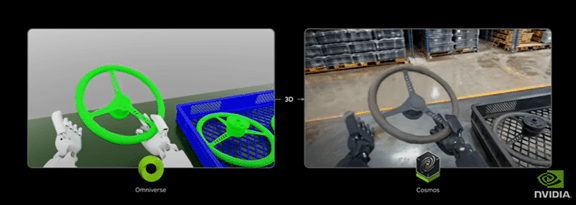

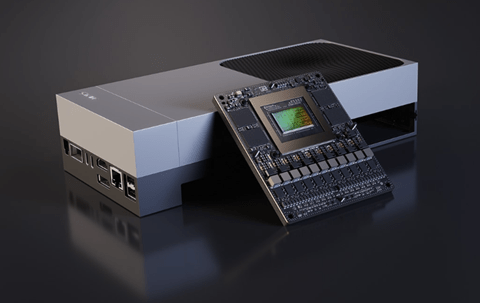

NvidiaはArmと提携し知的財産のライセンスを受け次世代GPUシステム「Vera Ruben」を開発した。このシステムは「Vera CPU」と「Ruben GPU」で構成されるスーパーチップとして製品化された(下の写真)。NvidiaはVera CPUの開発でArmから「Olympus」のライセンスを受け、これをベースに88コアの独自のCPUを開発した(下の写真、水色のチップ)。RubenがGPUとして数値演算を超高速で実行し(金色の二つのチップ)、VeraがCPUとしてシステムの制御などを実行する。Linuxなどの基本ソフトがVeraで稼働しシステム全体を制御する。

| 出典: Nvidia |

エッジプロセッサ

またNvidiaは、ロボットや自動運転車向けのプロセッサ「Jetson Thor」を提供しているが(下の写真)、ここでもCPU部分はArmのアーキテクチャを採用している。Jetson Thorはシングルチップ「Silicon-on-Chip」構成で、一つのチップにGPU「Nvidia Blackwell」とCPU「Arm Neoverse-V3AE」を搭載する。CPUはArmの「Neoverse」ファミリーのハイエンドモデル「V-Series」でクラウドやAIプロセッサとして使われる。

| 出典: Nvidia |

配送ロボット

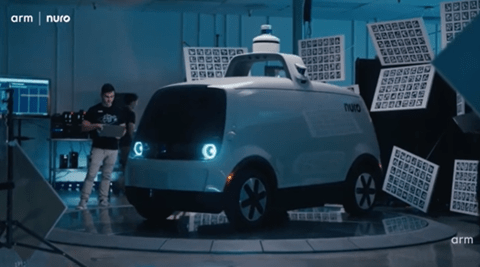

自動運転技術を開発するNuroはNvidiaのエッジプロセッサを使ってロボ配送車両を開発した(下の写真)。ロボタクシーを小売店舗向けに適用し、走るスーパーマーケットとして展開している。クルマのブレインとして「NVIDIA DRIVE AGX Thor」を搭載している。ArmはこのプロセッサのCPUの部分を司り、システムの制御を実行する。

| 出典: Arm |

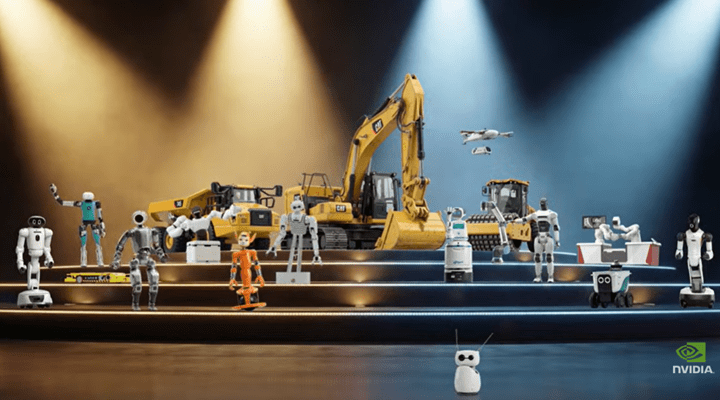

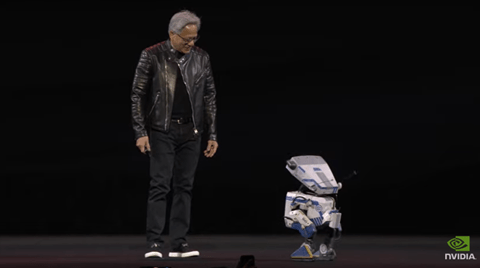

ヒューマノイド・ロボット

Boston Dynamicsはヒューマノイド・ロボット「Atlas」を開発している(下の写真)。Atlasは関係会社であるHyundai Motor(現代自動車)の製造工場に導入され、人間の作業員に代わりパーツのハンドリングを実行する。また、Boston DynamicsはGoogle DeepMindと提携し、フロンティアモデル「Gemini Robotics AI」を採用することを発表した。これにより、ロボットのインテリジェンスが格段に向上し汎用的なタスクを実行できると期待されている。AtlasはJetson Thorを搭載し、Nvidiaのロボット開発環境「NVIDIA Isaac Lab」で開発された。

| 出典: Boston Dynamics |

フィジカルAI市場が急成長

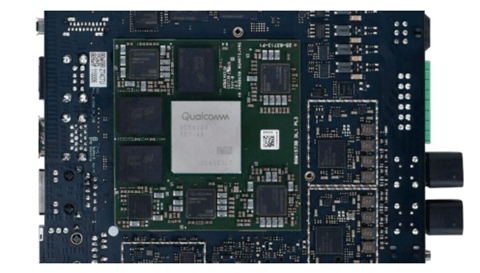

自動運転車やロボット向けのプロセッサではNvidiaが先行しており、これをQualcommが追う展開となっている。QualcommはフィジカルAIプロセッサとして「Dragonwing」(下の写真)を投入した。DragonwingはQualcommのCPU「Oryon」を搭載し、NPUと共にAI処理を高速で実行する。CPU「Oryon」はQualcommが設計したプロセッサであるが、ここにArmのアーキテクチャを採用している。具体的には、Armのインストラクション・セット(機械命令のセット)を実装し、ソフトウェアの互換性を担保する構成となる。Qualcomm Oryonは自動運転車やロボットで採用が始まり、フィジカルAI市場が急速に拡大している。

| 出典: Qualcomm |

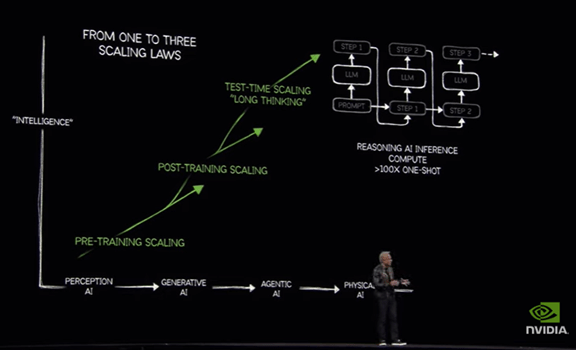

AIブームを陰で支える

ロボタクシーやヒューマノイド・ロボットでNvidiaやQualcommのAIプロセッサが使われ、製品開発が進み多彩な製品がリリースされている。GPUやNPUがエッジプロセッサのエンジンとなり注目を集めるが、その背後でArmベースのCPUが重要な役割を担っている。GPUやNPUはAIシステムの中の数値計算エンジンとして位置付けられ、CPUは基本ソフトを稼働させシステム全体を制御し効率的な演算を司る。多くのエッジプロセッサがArmアーキテクチャを採用しており、これによりソフトウェアの互換性が保証され、半導体を跨りシステムを稼働することができる。Armはクラウドなどデジタルな領域から、ロボティックスなどフィジカルな領域に事業を拡大し、AIブームを陰で支える。