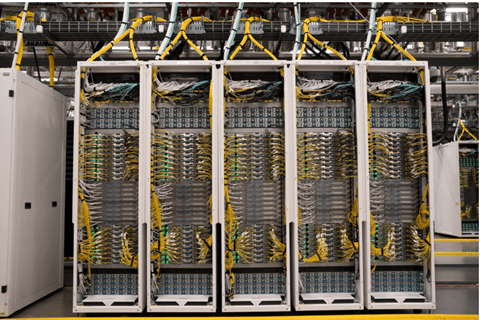

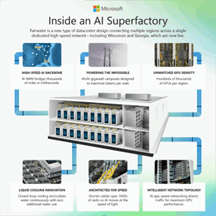

Microsoftはジョージア州にギガワット・データセンタ(下の写真)を建設しておりその概要を明らかにした。この施設はウィスコンシン州のデータセンタと高速通信で連結され、巨大計算環境「AIスーパーファクトリ(AI Superfactory)」実現する。ここでAGIとフロンティアモデルを開発する。MicrosoftはOpenAIとの提携契約を更新し、これからはフリーハンドで先進モデルを開発する。Microsoftにとって大きな転機で、先端技術をOpenAIに依存することなく、自社で独自にスーパーインテリジェンスの開発を進める。

| 出典: Microsoft |

AIスーパーファクトリとは

AIスーパーファクトリ(AI Superfactory)とは異なる州に建設されたデータセンタを高速ネットワークで連結し大規模計算環境を生み出す構想となる。Microsoftはジョージア州アトランタに最新のデータセンタを建設しており、これを高速ネットワーク「AI Wide Area Network (AI WAN)」でウィスコンシン州に建設しているデータセンタ(下の写真)と結合し、巨大データセンタを構築する。物理的に異なるデータセンタを統合し仮想の単一データセンタを生み出す。

| 出典: Microsoft |

AIスーパーファクトリの目的

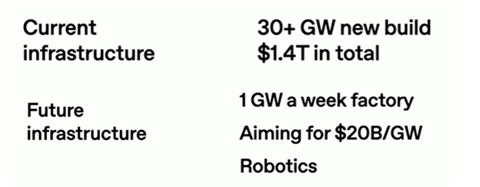

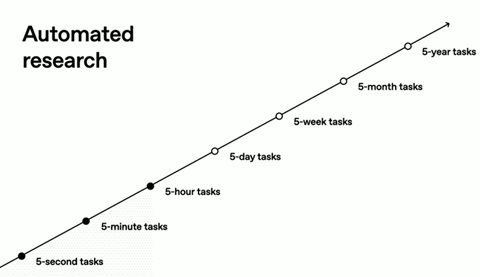

現行のデータセンタは膨大な数のアプリケーションを実行するために使われるが、AIスーパーファクトリは単一の巨大AIモデルを開発することをミッションとする。具体的には、AGIを含む次世代AIフロンティアモデルを開発するための計算機環境となる。現在は、AIフロンティアモデルの教育では開発期間が数か月に及ぶが、これを数週間に短縮する。現行のAIフロンティアモデルの規模は1T(パラメータの数が1兆)であるが、次世代モデルはこれが200Tから300Tに膨らみ、メガデータセンタが必要となる。このセンタはMicrosoftだけでなく、OpenAIが次世代モデルを開発するために提供される。

フェアウォータ・デザイン

Microsoftはジョージア州アトランタに建設しているデータセンタの概要を明らかにした。設計コンセプトは「フェアウォータ・デザイン(Fairwater Design)」と呼ばれ、Nvidiaの最新GPUサーバを高密度に配置することに加え、サーバのスペックの変更に対応できる柔軟な設計思想となっている。Microsoftはウィスコンシン州にデータセンタを建設しているが、これもフェアウォータ・デザインに準拠し、このコンセプトのセンタの数が増えつつある。

| 出典: Microsoft |

データセンタの構造

フェアウォータ・デザインでは最新の高速チップやラックが使われる。アトランタ・フェアウォータは「NVIDIA GB200 NVL72」(上の写真)が採用され、数十万ユニットの「Blackwell GPUs」を連結する。また、データセンタは二階建ての構造で単位面積当たりの計算機密度を最大にする(下の写真)。更に、GPUサーバは液冷式で、データセンタの冷却設備で水を使う必要がなく、環境への負荷を最小にする設計となる。

| 出典: Microsoft |

スーパーインテリジェンス部門設立

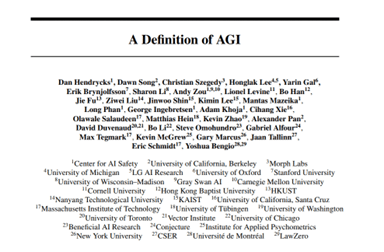

これに先立ち、Microsoftはスーパーインテリジェンスを開発するためのチーム「Microsoft AI Superintelligence Team(MAIST)」を設立した(下の写真)。このチームは「Humanist Superintelligence (HSI)」を開発することを目的とする。HISとは人間の知能を超えるスーパーインテリジェンスで、機能や性能に制限を設け、人間の価値に沿ったモデルを開発する。スーパーインテリジェンスを開発するためにAIスーパーファクトリが使われる。

| 出典: Microsoft |

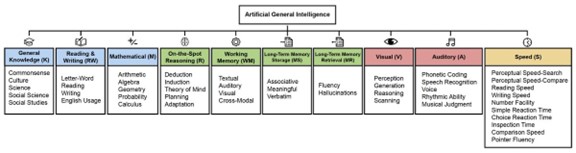

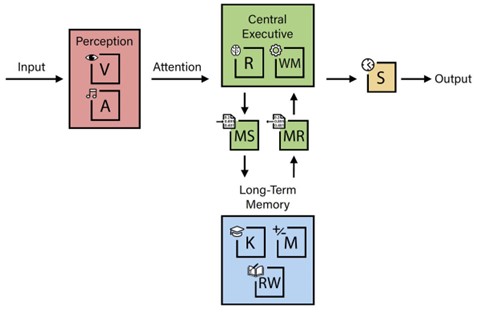

スーパーインテリジェンスの機能

Humanist Superintelligence (HSI)は人間の知能を上回るが、モデルを安全に制御するために、一定の枠組みの中で稼働させる。これによりHSIが独自に進化し暴走するのを抑止する。更に、HISは特定のタスクに特化したモデルで人間社会の問題を解決することを目的とする。その主要セグメントが「Medical Superintelligence」で、医療分野のスーパーインテリジェンスとして、高度な医療技術を実現する(下の写真)。また、「Energy Superintelligence」はエネルギー分野のスーパーインテリジェンスで、クリーンエネルギーの生成と貯蔵の研究を加速する。最終ゴールは核融合発電で、スーパーインテリジェンスがこの研究開発をサポートする。

| 出典: Microsoft |

OpenAIとの契約

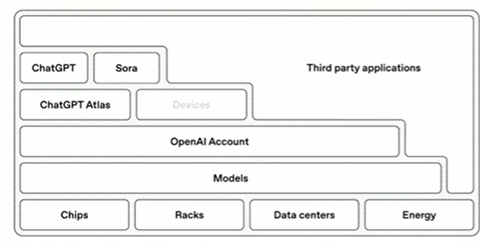

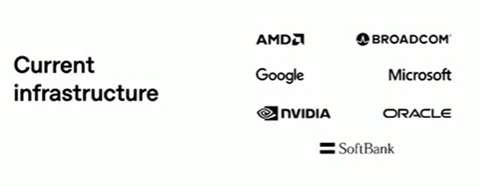

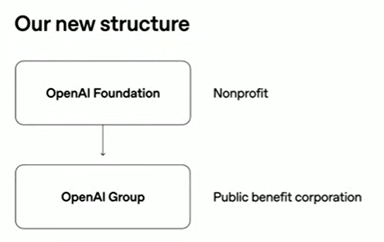

MicrosoftはOpenAIと提携しChatGPTなどフロンティアモデルを開発する環境を提供してきた。両社の契約によると、Microsoftは独自でAGIを開発することを制限され、OpenAIが主導的な地位を維持する構造となっていた。しかし、OpenAIの組織改編により新たな契約が締結されこの制約が解除された。Microsoftは独自にAGIやスーパーインテリジェンスを開発することができるようになった。このため、Microsoftは上述の「Microsoft AI Superintelligence Team」を立ち上げAGI・フロンティアモデルの開発に着手した。

協調と競合

両社の関係は新たな時代を迎え、Microsoftは継続してOpenAIに最新の計算機環境を提供しAGI開発をサポートする。また、MicrosoftはOpenAIのAIモデルをクラウド「Microsoft Azure」で独占的に提供する権利を維持する。一方、MicrosoftはAGI・フロンティアモデルを独自で開発するため、OpenAIと直接競合する関係となる。これからはMicrosoftとOpenAIは協調しながら競合するという複雑な関係となる。

| 出典: Microsoft |