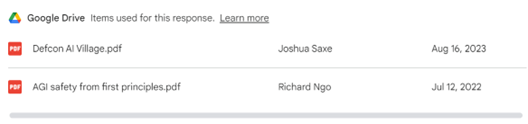

サンフランシスコがAI開発のハブとなっている。AIのスタートアップ企業がここに集結し、生成AIを中心に、次世代モデルを開発している。OpenAIはこの地で創業し、これを取り巻くように、AIスタートアップ企業が相次いでオフィスを開設している。ベンチャーキャピタルもここに拠点を移動し、AIのエコシステムが形成されている。インターネットは「シリコンバレー」で誕生したが、AIのブレークスルーは「セレブラルバレー」で起こる。

| 出典: Google Maps |

セレブラルバレーとは

セレブラルバレー(Cerebral Valley)とは、サンフランシスコのヘイズバレー(Hayes Valley、上の写真)の俗称である。いま、ここに生成AIの新技術を開発するスタートアップ企業が集結し、シリコンバレーに対峙して、セレブラルバレー(頭脳の谷)と呼ばれている。ここは、サンフランシスコ南部に位置し、近くにはUberやX(元Twitter)の本社があり、ハイテク地区となっている。

インキュベータ

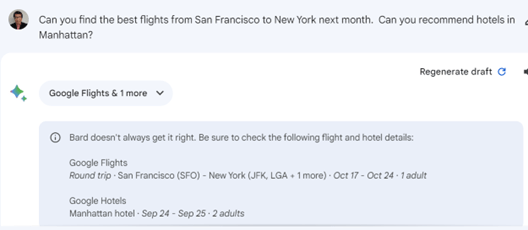

この地区のすぐ南にはOpenAIの本社があり、セレブラルバレーはChatGPTなど生成AIを基盤とする技術開発の拠点となっている。ここにインキュベータが開設され、創業間もないスタートアップ企業が入居し、AI技術を開発している。住宅をオフィススペースとして提供し(下の写真)、ここでエンジニアたちが、生活を共にしながら技術開発を進める。生活共同体の方式で、生まれたばかりの生成AIを基盤とし、ここで新しいアイディアを生み出す。

| 出典: Google Maps |

OpenAI経済圏

サンフランシスコが生成AI開発のハブとなったが、それには理由がある。OpenAIが開発したChatGPTは、企業や消費者で使われるだけでなく、AI開発のコミュニティに大きな影響を及ぼした。今までは、AIを開発するにはデータサイエンスなど高度な技量を要したが、今では、ChatGPTを使うことで、参入の敷居が大きく下がった。誰でもAIを開発することができ、多くのエンジニアが独自のアイディアを製品化している。ChatGPTが生成AI開発ブームの起爆剤となり、多彩な製品が開発されている。(下の写真、OpenAIの本社)

| 出典: Google Maps |

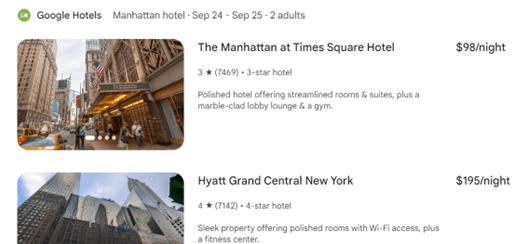

大手スタートアップ企業

サンフランシスコのダウンタウンには、AIスタートアップの中でも、大手企業が集結している。ベンチャーキャピタルから巨額の投資を受け、生成AIのファウンデーションモデルを開発している。豊富な資金を元に、大規模な言語モデルを開発し、OpenAIのGPT-4を凌駕するモデルを目指している。その代表がAnthropicで、ダウンタウンにオフィスを構え(下の写真、中央のビル)、次世代の生成AI基盤技術を開発している。

| 出典: Google Maps |

サンフランシスコの転換期

コロナのパンデミックで、企業は一斉にリモートワークに移り、サンフランシスコからエンジニアの姿が消えた。オフィススペースは不要となり、空室が目立つようになった。この影響で、近辺のレストランや小売店は客足が遠くなり、通りはひっそりとし、治安も悪化した。しかし、ChatGPTでAI開発ブームに火が付き、多くの企業がサンフランシスコにオフィスをオープンし、活気が戻ってきた。

リモートワークでイノベーションは生まれない

シリコンバレーでインターネット技術が誕生したが、いま振り返ると、エンジニアたちは寝食を共にしながら、共同で技術開発を進めた。独自のアイディアを、他者に先駆けて市場に投入するため、オフィスに寝起きしながらプログラミングを続けた。生まれたばかりの柔らかいコンセプトを製品に仕上げるには、技術者同士の密接なコミュニケーションが求められる。いま、生成AIがこのフェイズに当てはまり、顔を突き合わせてブレーンストーミングする環境が必要となる。

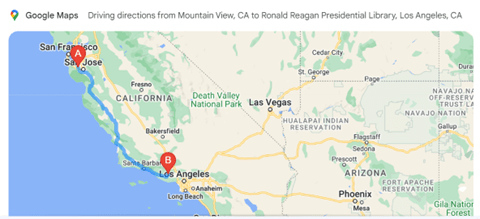

| 出典: Google Maps |

ベンチャーキャピタルも注目

ベンチャーキャピタルもサンフランシスコがAI開発のハブになっていることに着目している。最大手のアクセラレータである「Y Combinator」は、オフィスをシリコンバレーからサンフランシスコに移転した(上の写真、一番手目のビル)。Y Combinatorは、生成AIのスタートアップ企業に重点的に投資し、第二のOpenAIを生み出すことを目論んでいる。セレブラルバレーで生成AIのブレークスルーが起きる可能性は高く、全米の注目を集めている。