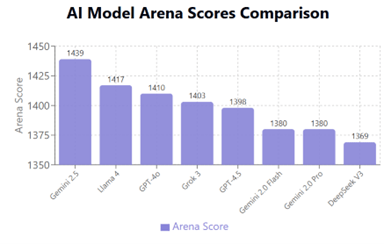

Metaは会社創業以来の危機に直面している。MetaはAI最新モデル「Llama 4」を投入したが、ベンチマーク性能は先頭集団に及ばず、AI開発での出遅れが顕著になった。ハイエンドモデル「Behemoth」は出荷時期が延伸され、開発が不調であることを裏付けている。CEOのMark ZuckerbergはAI開発体制を一新し「スーパーインテリジェンス研究所」を創設した。スタートアップ企業Scale AIを買収し、また、OpenAIなどから著名研究者を引き抜き、研究体制を大幅に強化した。(下の写真、スーパーインテリジェンス研究所のイメージ)

| 出典: Generated with Google Imagen 4 |

MetaのAI開発が難航

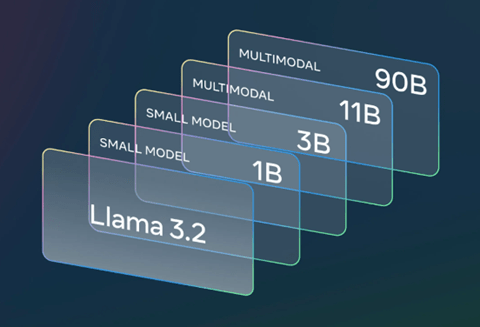

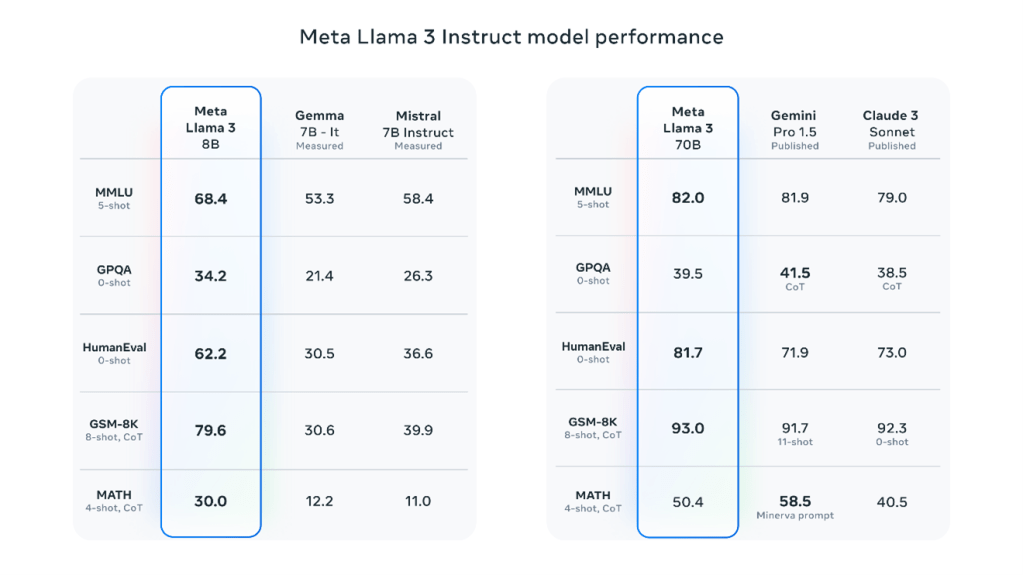

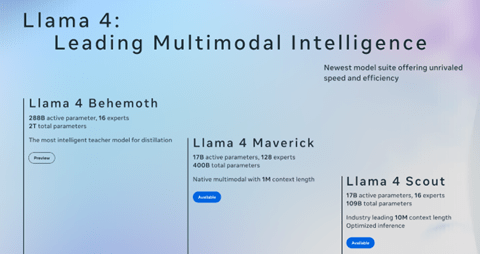

MetaはAIモデル「Llama」を開発し、そのコードや重みをオープンソースとして公開してきた。初代のLlamaからLlama 3はトップレベルの性能を示し、開発コミュニティで幅広く使われている。しかし、Metaは今年4月にLlama 4をリリースしたが(下の写真)、ミッドレンジモデル「Maverick」はOpenAIやGoogleの対抗モデルと比較して、推論機能が大きく劣ることが明らかになった。また、実社会でのベンチマーク「LM-Arena」では30位の成績で、トップグループからの出遅れが顕著となった。

| 出典: Meta |

スーパーインテリジェンス研究所

Zuckerbergはこれを重大な危機と認識し、MetaのAI開発体制を一新し、「スーパーインテリジェンス研究所(Superintelligence Labs)」を設立した。研究所のミッションは次世代モデルの開発で、人間の知能を凌駕するスーパーインテリジェンスを開発する。MetaはAIスタートアップ企業「Scale AI」に143億ドル投資し、創業者のAlex Wangを研究所の代表に任命した。また、OpenAIやGoogleから著名研究者を引き抜き、AI開発のドリームチームを結成した。

| 出典: Generated with Google Imagen 4 |

スーパーインテリジェンス研究体制

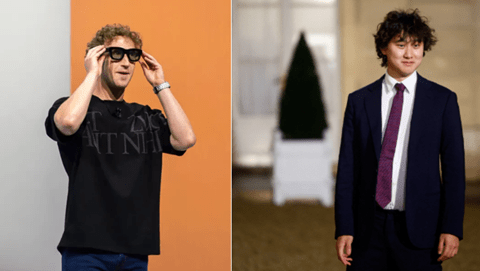

スーパーインテリジェンス研究所はCEO直属組織で、所長のWang(下の写真右側)がZuckerberg(左側)に直接レポートする。現在、コアの研究者の数は50名と言われるが、Zuckerbergは業界の著名研究者をアグレッシブに採用している。MetaはOpenAIの主要研究者にオファーを出し、採用ボーナスとして1億ドルを提示したとされる。この他に、Google、Perplexity、Safe Superintelligenceの研究者の採用を試みている。

| 出典: Stocktwis / CNBC |

採用された研究者のプロフィール

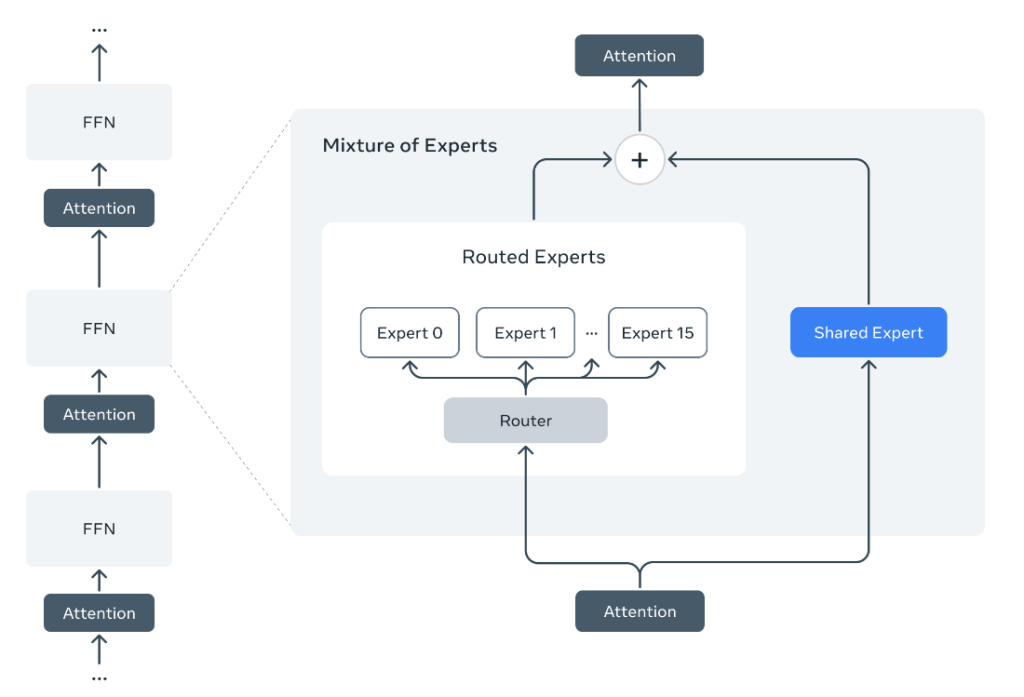

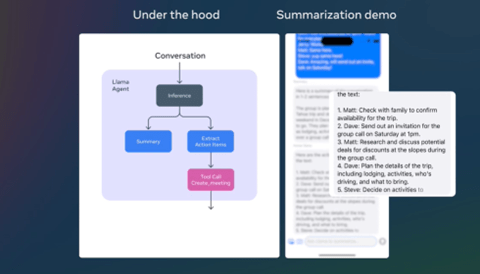

実際に採用された研究者の経歴を見ると、Metaの次世代モデル開発の戦略を読み取ることができる。MetaのAI開発が難航している理由は推論モデルで、このノウハウを持つ研究者を重点的に採用している。更に、MetaはスマートグラスをAIで強化することでインテリジェントなウエアラブルを製品化する。このため、ビジョン・トランスフォーマなどマルチモダルの研究者を数多く採用した。また、所長のWangはデータやインフラの第一人者で、推論モデル開発で必須となる教育データ生成のノウハウを持つ。

スーパーインテリジェンス研究所の開発テーマ

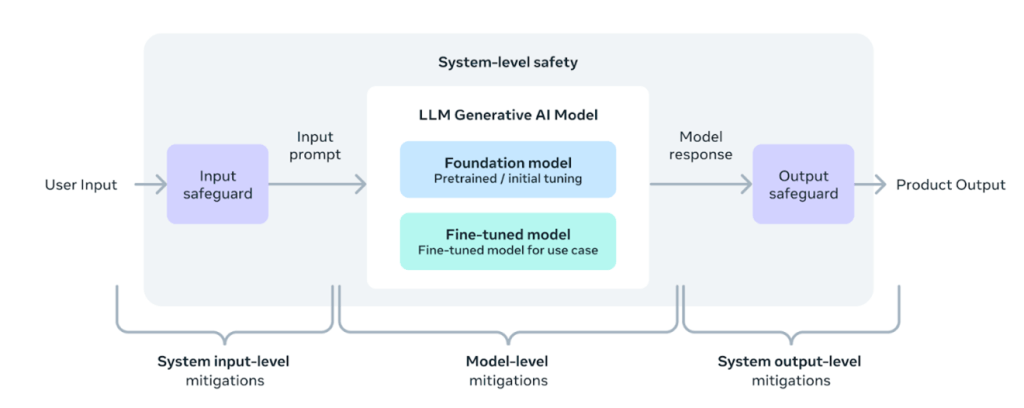

スーパーインテリジェンス研究所のミッションは人間の知能を凌駕するAIモデルを開発することにある。技術的には、上述の推論機能を強化するため、強化学習(Reinforcement Learning)や思考の連鎖(Chain of Thought)が研究テーマとなる。また、AIが実社会とインタラクションするために「世界モデル」を開発する。世界モデルとはAIシステムが3D物理社会のコンテキストを理解し、次の挙動を予測する能力となる。スーパーインテリジェンスに加えロボティックにおける重要な基礎技術となる。また、人間の知能を上回るAIシステムを安全に制御するために、セーフティ技術の開発が必須となる。(下の写真、Metaの本社キャンパス)

| 出典: Meta |

オープンソース戦略の見直し

MetaはAI開発におけるオープンソース戦略の見直しを進めている。MetaはLlamaシリーズをオープンソースとして公開することで、コミュニティのAI開発を支え社会に多大な貢献をしている。一方、高度なAIをオープンソースとして開発することで、マイナスの面が顕著になってきた。特に、推論モデルにおいてこれをオープンソースとして公開すると、AIの思考プロセスが開示され、開発競争において不利になる。また、スーパーインテリジェンスなど高度なモデルを公開することは敵対国や攻撃団体に悪用されるリスクが高まり国家安全保障の重大な問題となる。Metaはスーパーインテリジェンスにおけるオープンソース戦略の見直しを進めている。

LeCunとの関係

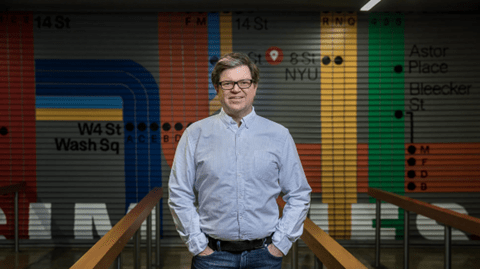

MetaのAI開発が低迷した理由の一つにYann LeCun(下の写真)のインテリジェンス開発に関するビジョンが影響している。LeCunはMetaのAI研究所「Fundamental AI Research (FAIR)」(現在は「Meta AI」)の所長としてAI開発をリードしてきた。LeCunは人間の知能に匹敵するAGI開発に懐疑的なポジションを取り、いまの言語モデルを拡張してもAGIには到達できないと考える。Metaが独自の手法を探索している間に、OpenAIやGoogleは言語モデルや推論モデルを拡張しAGIを目指し大きな成果を上げている。ZuckerbergはLeCunの手法と一定の距離を置き、スーパーインテリジェンス研究所を設立し次世代モデルの開発にリソースを投入する。

| 出典: Meta |

臨戦態勢で先端技術を開発

AI先進モデルの開発ではアルゴリズム、データセンタ、データがコア技術となり、研究開発の成否を握る。アルゴリズムにおいては、先端モデルの開発に従事している研究者は20人程度と言われている。これら最先端研究者がOpenAIやGoogleで次世代モデルを生み出している。MetaがOpenAIから数多く研究者を引き抜いたが、OpenAIもGoogleから研究者をスカウトした。Zuckerbergは参謀本部(War Room)を創設し、ここで臨戦態勢でAI開発を推進する。Metaはトップ集団に追い付くことができるのか、スーパーインテリジェンスの開発が注目される。(下の写真、MetaデータセンタのNvidia GPUクラスター)

| 出典: Nvidia |