Google DeepMindは生成AIでロボットの頭脳「RT-2」を開発した。生成AIはチャットボット「Bard」のエンジンとして使われているが、これをロボットに適用した。RT-2は人間の言葉を理解し、カメラの映像を読み込み、ロボットのアクションを計算する。この手法は、ロボットは教育されていない命令を実行できることを意味し、汎用ロボットの開発に向けて大きな技術進化となる。

| 出典: Google DeepMind |

RT-2とは

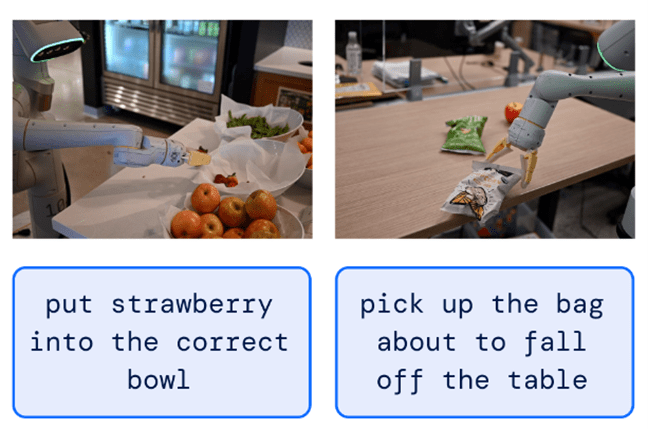

Google DeepMindはロボットの頭脳「Robotic Transformer 2 (RT-2)」を開発した。名前の通り、言語モデル「Transformer」で構成されるロボットで、言葉(人間の命令)とイメージ(カメラの映像)をアクション(ロボットの動作)に翻訳する機能を持つ。人間の指示をそのままロボットが実行することを意味し、RT-2は初めての環境でもタスクを実行することができる。RT-2はロボットハードウェアに実装され、カメラで目の前のオブジェクトを捉え、ロボットアームが処理を実行する(上の写真)。

汎用ロボットの開発

GoogleはTransformerを搭載することで汎用ロボットを開発するアプローチを取る。現在のロボットは、特定のタスク(リンゴを掴むなど)を繰り返し練習し、スキルを獲得する。これに対し汎用ロボットは、特定のスキル(リンゴを掴むなど)を習得すると、それを別のタスク(バナナを掴むなど)に応用する。人間のように学習したことを汎用的に使いこなす能力で、ロボット開発のグランドチャレンジとなっている。

RT-1とRT-2を開発

言語モデル「Transformer」をロボットに適用する試みは「RT-1」で始まり、ロボットは学習したスキルを別のロボットに移転することが可能となった。RT-2はRT-1が学習したことを継承し、更に、ウェブ上のデータを学び、世界の知識を習得した。これにより、人間の言葉をロボットの言葉に翻訳し、初めての環境でもタスクを実行し、ロボットの汎用性が向上した。

RT-2の成果:初めてのタスク

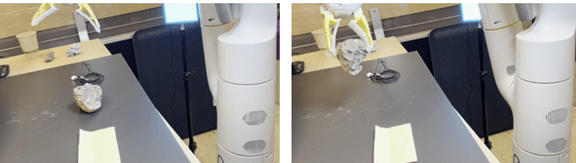

RT-2はカメラで捉えたイメージだけで、指示された命令を実行する。具体的には、ロボットが「イチゴを掴んでボールに移す」よう指示されると、RT-2はカメラで捉えたイメージから、次のアクションを予想し、これをロボットが実行する(下の写真左側)。今までのロボットは、イチゴを掴んでボールに移す操作を何回も練習して、このスキルを獲得するが、RT-2は学習していないスキルでも、これを実行することができる。同様に、「テーブルから落ちそうな包みを掴んで」と指示されると、RT-2は初めてのタスクでもこれを実行する(右側)。

| 出典: Google DeepMind |

RT-2の成果:初めての環境

RT-2は今までに学習したことのない環境で、命令を実行することができる。RT-2は、見たことのないオブジェクトを操作できる(下の写真左側)。また、学習していない背景(中央、テーブルクロス)や、学習していない環境(右側、キッチンのシンク)において、指示されたタスクを実行できる。このスキルは汎用化(Generalization)と呼ばれ、学習したことを元に、新しい環境でその知識を応用し、タスクを実行できる能力を指す。

| 出典: Google DeepMind |

RT-2の成果:推論機能

RT-2のモデルが更に改良され、ロボットは推論機能を獲得した。これは「考察の連鎖(chain-of-thought)」と呼ばれるもので、ロボットは複数の思考ステップを経て結論を導き出す。ロボットは「目的」と「アクション」を理解してそれを実行する。具体的には、ロボットに「くぎを打つ」という目的を示し、このために「どのオブジェクトを使えるか」と聞くと、ロボットは「紙」、「石」、「コード」の中から(下の写真左側)、「石」を取り上げる(右側)。RT-2は「金槌」が無い時は「石」を代用できることを推論した。

| 出典: Google DeepMind |

ベンチマーク結果

RT-1とRT-2がタスクを実行できる能力を比較すると、その差は歴然としており、大規模言語モデルを適用することで、性能が向上することが示された(下のグラフ)。具体的には、既に学習したタスク「Seen」を実行できる割合については、両者で互角となる(左端)。しかし、初めてのタスク「Unseen」に関しては、RT-2が実行できる割合がRT-1を大きく上回る(右端)。RT-2は、人間と同じように、学習したことを新しい環境に適用できることを意味し、汎用的に学習する機能を獲得した。(RT-1は灰色のグラフ、RT-2は紫色と薄青色のグラフ。)

RT-2は大規模言語モデルの種類により二つのモデルが開発された。二つの言語モデルは:

- PaLM-E:言語モデル「PaLM」をロボット向けに最適化。言語とイメージを処理。

- PaLI-X:言語モデル「PaLI」の小型モデル。多言語とイメージを処理。

| 出典: Google DeepMind |

ロボット開発は進まないが

大規模言語モデル「Transformer」はChatGPTなどチャットボットのエンジンとして使われ、人間の言語能力を凌駕し、社会に衝撃を与えた。Googleはこれをロボットに適用することで、研究開発におけるブレークスルーを目指している。デジタル空間のAIは劇的な進化を続けているが、ロボットなど実社会におけるAIは目立った進展が無い。生成AIでこの壁を破れるのか、世界の研究者が注目している。